#201 Agent oder Workflow? – Checkliste für Einsteiger

Worum geht es in diesem Artikel?

Der Blog Post zeigt eine Checkliste für Einsteiger zur Workflow Automatisierung ob Agenten, Workflows oder hybride Systeme sinnvoll sein könnten

Checkliste für Einsteiger

Zielgruppe: Menschen, die zum ersten Mal mit KI‑Automatisierung arbeiten (Produktmanager, Gründer, Team‑Leads ohne LLM‑Vorerfahrung). Was du hier bekommst: Eine Schritt‑für‑Schritt‑Entscheidungshilfe in Alltagssprache. Jedes Kapitel erklärt warum du etwas prüfen musst, was dabei schiefgehen kann und wie echte Firmen das gelöst haben – immer im Vergleich Agent vs. klassischer Workflow.

Die Checkliste ist als ein Community Projekt gedacht, wenn du Anmerkungen und Verbesserungen zur Checkliste hast, dann schreibe deine Kommentare hier: Link

Agent oder Workflow? – Checkliste für Einsteiger

Zielgruppe: Menschen, die zum ersten Mal mit KI‑Automatisierung arbeiten (Produktmanager, Gründer, Team‑Leads ohne LLM‑Vorerfahrung). Was du hier bekommst: Eine Schritt‑für‑Schritt‑Entscheidungshilfe in Alltagssprache. Jedes Kapitel erklärt warum du etwas prüfen musst, was dabei schiefgehen kann und wie echte Firmen das gelöst haben – immer im Vergleich Agent vs. klassischer Workflow.

1 | Brauche ich überhaupt einen Agenten?

Stell dir einen Workflow wie ein Kochrezept vor: Die Schritte stehen fest, jedes Mal gleich.

Ein Agent ist eher wie eine erfahrener Köch*in, die spontan entscheidet: „Oh, keine Karotten im Haus? Dann nehme ich Paprika.“

Entscheidungsregel:

Wenn du die Frage mit „Ja“ beantwortest ⇒ Agent einsetzen.

Wenn du „Nein“ antwortest ⇒ Klassischer Workflow reicht.

| Frage an dein Projekt | Warum ist das wichtig? | Agent – Praxis | Workflow – Praxis |

|---|---|---|---|

| 1️⃣ Schreiben Nutzer freie Texte mit vielen Varianten? | Wenn jede Anfrage anders klingt, bräuchtest du unendlich viele “wenn … dann …”‑Zeilen. Ein Agent erkennt selbst, worum es geht. | Klarna: Kunden fragen in 23 Sprachen alles Mögliche (Rückgabe, Rechnung, Passwort …). | Paket‑Tracker: Frage ist immer „Wo ist mein Paket?“. |

| 2️⃣ Muss das System aus mehreren Datenquellen wählen? | Stell dir 10 Schränke mit Zutaten vor: Agent greift je nach Bedarf in den richtigen. Workflow müsste für jede Kombination ein Rezept haben. | Vodafone: Agent übersetzt Fragen in SQL, zieht Live‑Metriken, zeichnet Diagramme. | Nacht‑Export: Ein Script holt jede Nacht dieselben Tabellen, speichert CSV. |

| 3️⃣ Gibt es Folgefragen? | Ein Gespräch braucht Gedächtnis. Agenten bringen dieses „Kurzzeitgedächtnis“ mit; bei Workflows musst du aktiv einen Session‑Store (Redis, DB) anlegen. | Podium‑Sales‑Bot: Klärt Wunsch, schlägt Termin vor, bestätigt per SMS. | Dialog‑Flow mit Session‑Store: Chat‑Workflow speichert Kontext; Entwickler legen explizit fest, was persistiert wird. |

| 4️⃣ Soll das System etwas recherchieren? | Wenn niemand weiß, wie viele Schritte nötig sind, ist ein festes Rezept zu starr. | VC‑Scout: Agent durchsucht 100 k Start‑ups, filtert, fasst Findings zusammen. | Preis‑Lookup: Input → fixer Preis zurück. |

| 5️⃣ Muss die Antwort in < 0,1 Sek. da sein? | Agenten fragen oft mehrfach beim Modell nach → dauert Sekunden und kostet Tokens. | – Agent wäre zu langsam/teuer. | Börsen‑Algo: feste Regeln, läuft lokal in Millisekunden. |

Daumenregel: ✔ Freitext + viele Datenquellen + Folgefragen → Agent

✔ Formular + klarer Ablauf → Workflow

—:**

✔ Wenn Freitext + viele Datenquellen + Folgefragen → Agent.

✔ Wenn festes Formular + klarer Ablauf → Workflow.

2 | Kontext & System‑Prompt – Warum so wichtig?

Kurz gesagt: Das Sprachmodell ist wie eine neuer Mitarbeiter*in.

Kontext = alle Unterlagen, die du ihr regelmäßig gibst.

System‑Prompt = ihre schriftliche Jobbeschreibung.

Was kann passieren, wenn du hier schluderst?

- Ein Agent halluziniert („Ihre Rechnung beträgt 0 €“) → peinlich oder teuer.

- Er stellt immer wieder Rückfragen, obwohl du die Antwort hast → frustriert Nutzer.

- Er ruft falsche Datenbanken auf → Datenschutz‑Problem.

5 Goldene Schritte – Dein Sicherheitsnetz für Agenten

Warum überhaupt diese Schritte?

Ein KI‑Agent ist wie ein sehr talentierter, aber auch vergesslicher Praktikant: Gibst du ihm alles Nötige in der richtigen Form, erledigt er den Job brillant. Bekommst du das Briefing falsch, macht er Fehler, kostet Geld – oder beides. Die fünf Schritte unten haben sich in fast jedem erfolgreichen Agenten‑Projekt als Mindest‑Set erwiesen.

Schritt 1 – Datenquellen sammeln

- Was ist das? Eine simple Tabelle (CSV, Notion, Google Sheet), in der du alle Datenquellen auflistest, die der Agent jemals braucht – inklusive Zugriffsweg und Aktualität.

- Warum? Fehlt eine Quelle, rät das Modell. Das verursacht Halluzinationen oder Rückfragen.

- Praxis‑Tipp für Agenten: Setze pro Quelle ein “letztes Update”-Feld. In der Prompt‑Logik kannst du dann neuere Daten priorisieren.

- Workflow‑Äquivalent: Ein Cron‑Script, das eine API abruft. Hier reicht Comments im Code – keine große Liste nötig.

Schritt 2 – RAG = Retrieval Augmented Generation

- Was ist das? Der Agent sucht sich nur die relevanten Text‑Schnipsel (Chunks) aus deiner Wissensbasis, statt alles in den Prompt zu kippen.

- Warum? LLM‑Kontext = kostbar (Token = Geld). Weniger Ballast → günstig & schnell.

- Anfänger‑Bild: Du fragst die Bibliothekarin nach einem Kapitel, nicht dem ganzen Buch.

- Agent‑Beispiel: SQL‑Assistent holt erst das Schema & Beispiel‑Rows, dann fragt GPT – spart ~80 % Tokens.

- Workflow‑Beispiel: Batch‑Job lädt komplette Tabelle offline, LLM gar nicht involviert.

Schritt 3 – Klarer System‑Prompt

- Was ist das? Eine Checkliste für deinen Agenten: Rolle, Stil, Tabus, Stop‑Kriterium.

- Warum? Ohne diese Leitplanken verhält sich das Modell unvorhersehbar – wie ein Praktikant ohne Arbeitsanweisung.

- Best Practice: Packe Regeln in Kommentare‑Blöcke (

<!-- RULE: ... -->) und versieh jede Änderung mit einer Git‑Version. - Workflow‑Kontrast: Eine SQL‑Pipeline generiert CSV; da gibt es keinen Fließtext und somit keinen Prompt.

Schritt 4 – Tool‑Schema beschreiben

- Was ist das? Ein JSON‑Schema, das jeder Tool‑Call erfüllen muss (Name, Parameter‑Typen, Beispiel‑Call, Error‑Codes).

- Warum? Das LLM kann so nur gültige Aufrufe generieren. Falscher Parameter? → Schema‑Validator stoppt, bevor Schaden entsteht.

- Agent‑Beispiel: Funktionsschema

run_sql(query:str, max_rows:int)verbietetDELETE‑Statements durch Regex‑Guard. - Workflow‑Beispiel: In Python ist die Funktion fest im Code – Typos führen zu Compile‑Errors; kein LLM‑Risiko.

Schritt 5 – Testen & Loggen

- Was ist das? Ein goldenes Testset (z. B. 50 typische User‑Fragen) plus Logging jeder Agent‑Entscheidung.

- Warum? LLMs sind probabilistisch. Ohne Regression‑Tests kann sich Qualität über Nacht verschlechtern.

- Agent‑Routine: CI‑Pipeline: Bei jedem Prompt‑Update laufen die 50 Tests, Ampel grün/rot.

- Workflow‑Routine: Klassische Unit‑Tests decken deterministische Pfade ab, keine Stochastik.

Merksatz für Einsteiger:

Agent ohne diese 5 Schritte = Blackbox.

Workflow ohne diese 5 Schritte = meistens okay, weil der Ablauf fix im Code steckt.

2.6 Brauche ich für diese Aufgabe wirklich Agent‑Komplexität?

Brauche ich für diese Aufgabe wirklich Agent‑Komplexität? Brauche ich für diese Aufgabe wirklich Agent‑Komplexität?

| Kontext‑/Prompt‑Aufgabe | Agent lohnt sich, weil … | Workflow reicht, weil … |

|---|---|---|

| Benutzer liefern freie Texte, du musst passende Fakten herausziehen | LLM + RAG erkennt Schlüsselwörter, holt nur nötige Wissens-Snippets. | Formular zwingt Nutzer, „Bestell‑ID“ einzugeben; Script setzt ID in SQL, kein LLM nötig. |

| Mehrere Tools können dieselben Daten liefern, Agent soll entscheiden | Agent wählt crm_live oder crm_archive je nach Alter des Falls. | Es gibt genau eine API, die immer passt. |

| Antwort muss individuell formuliert werden (Ton, Sprache, Personalisierung) | System‑Prompt steuert Stil („freundlich, duzend“), Agent baut Fließtext. | PDF‑Bericht wird als Tabelle exportiert, kein Text nötig. |

| Policies ändern sich häufig (Rabattregeln, Datenschutz) | Prompt oder Wissens‑Base lässt sich ohne Code‑Änderung updaten. | Regeln sind in Code gegossen & ändern sich selten (z. B. feste Mehrwertsteuer). |

| Sensible Daten dürfen nie ausgegeben werden | Agent‑Guardrail prüft Ausgaben, maskiert PII dynamisch. | Script gibt nur vordefinierte Spalten aus, keine Gefahr. |

Merke: Wenn jede Zeile in Spalte „Workflow reicht“ auf dein Projekt zutrifft, spare dir den Agent und die aufwändige Prompt‑Pflege. Kommt auch nur eine der Agent‑Gründe häufig vor, lohnt es, die Schritte 2.1–2.5 wirklich sauber umzusetzen.

📝 LangChain‑Analyse: Produktions‑Logs zeigen, dass die meisten Agent‑Fehler auf fehlenden/falsch formatierten Kontext oder unklare Prompts zurückgehen – nicht primär auf das Modell selbst.

Quellen KurzfassungKurzfassung

¹ LangChain Case Study „Klarna AI Assistant Automates Support“ (2025)

² LangChain × Podium Case Study „Reducing Developer Load with LangSmith“ (2025)

3 | Typische Stolperfallen – Agent vs. Workflow

Warum dieses Kapitel? Selbst mit guter Planung tauchen bei Agenten Probleme auf, die klassische Workflows kaum treffen. Unten stehen die fünf häufigsten Pannen, jeweils mit Agent‑Sofortmaßnahme, nachhaltiger Lösung und dem Grund, warum der gleiche Fehler bei rein deterministischen Workflows selten ist.

| Stolperfalle | Warum passiert das? | Agent – Schnellpflaster | Agent – Dauerlösung | Workflow – Warum hier selten? |

|---|---|---|---|---|

| Halluzination | Dem LLM fehlen Fakten – es „rät“. | Prompt: „Wenn unsicher, antworte Unbekannt.“ | RAG + Output‑Schema + Fakten‑Self‑Check. | Workflow liefert feste DB‑Werte; kein Freitext nötig. |

| Endlos‑Schleife | Tool‑Output unverständlich → erneuter Call. | Schrittzähler, nach 5 Versuchen abbrechen. | Regex‑Guardrail + Human‑Approval. | Script hat Retry‑Limit und bricht deterministisch ab. |

| Falsches Tool | Ähnliche Tool‑Namen | Prompt‑Beispiele präzisieren. | RLHF/DSPy‑Tuning auf Logs. | Workflow ruft exakt einen Endpunkt. |

| Token‑Kosten eskalieren | Zu viel Kontext, Debug‑Logs an. | Ältere Tokens trimmen; Streaming‑Antworten. | Auto‑Trimmer + Budget‑Alarm. | Keine LLM‑Tokens, Kosten planbar. |

| Prompt‑Drift | Prompt‑Änderung ohne Test | Prompt‑Datei in Git + PR‑Review | CI‑Eval + Canary‑Rollout | Config‑Änderungen laufen durch Unit‑Tests. |

4 | Betrieb & Monitoring nach dem Launch

Warum wichtig? Ein Agent ist nie „fertig“ – Modelle, Daten und Prompts ändern sich ständig. Betrieb ohne Monitoring endet schnell in unvorhersehbaren Kosten oder Halluzinationen.

4.1 Grundausstattung

| Must‑Have | Nutzen | Tool‑Beispiel |

|---|---|---|

| Logging | Vollständige Nachverfolgbarkeit | LangSmith, OpenTelemetry |

| Budget‑Alerts | Schutz vor Token‑Überraschungen | Cloud‑Usage‑Dashboard |

| Golden Testset | Früherkennung von Qualitäts‑Drift | 20–50 repräsentative Queries |

| Canary‑Rollout | Sicheres Ausrollen neuer Prompts | Feature‑Flags (LaunchDarkly) |

| Fallback‑Plan | Service bleibt erreichbar | FAQ‑Fallback oder E‑Mail‑Escalation |

4.2 Tägliche Agent‑Ops‑Routine

- Dashboard‑Check – Kosten, Fehlerrate, Halluzination‑Score.

- Bei Ausreißern – Traces untersuchen, Prompt anpassen.

- Prompt‑Update – PR → CI‑Eval → Canary (5 % Traffic).

- Wöchentlich – Golden‑Set erweitern, RAG‑Index refresh.

- Monatlich – Kosten‑Review, Modell‑Upgrade prüfen.

4.3 Wann Workflow statt Agent?

| Signal | Besser Workflow, weil… |

|---|---|

| Identische Anfrage > 95 % | deterministischer Code günstiger und stabiler |

| Antwort muss < 100 ms sein | LLM‑Latenz zu hoch |

| Audit erfordert 100 % Trace | Workflow leichter prüfbar |

Quellen (kurz)

¹ LangChain Case Study „Klarna AI Assistant Automates Support“ (2025)

² LangChain × Podium Case Study „Reducing Developer Load with LangSmith“ (2025)

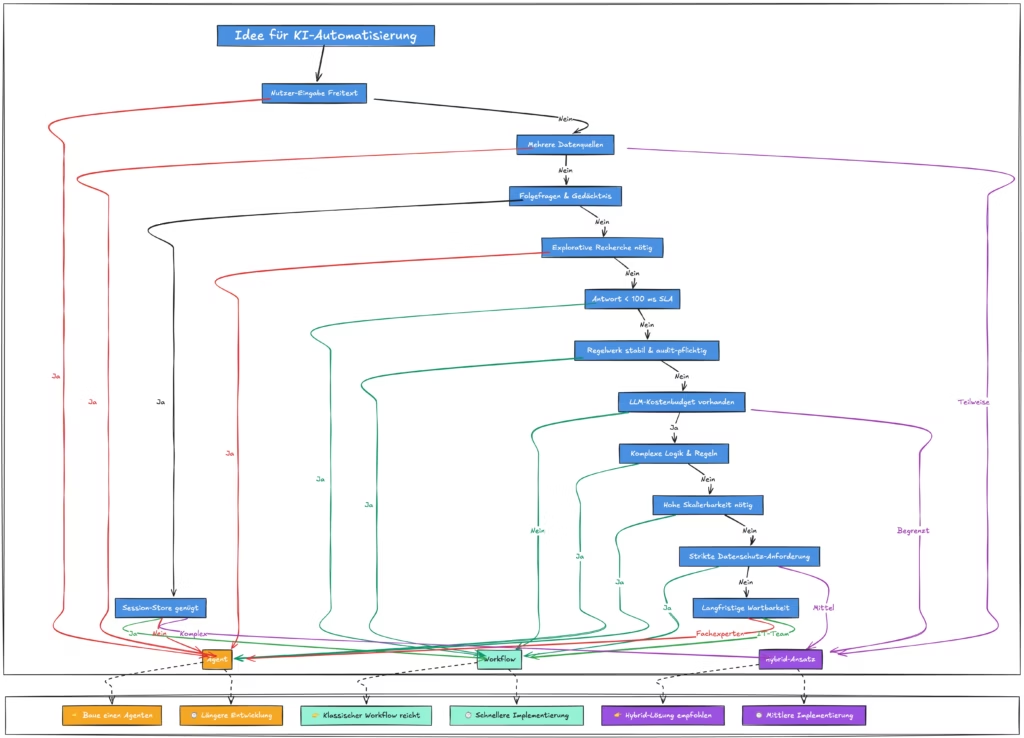

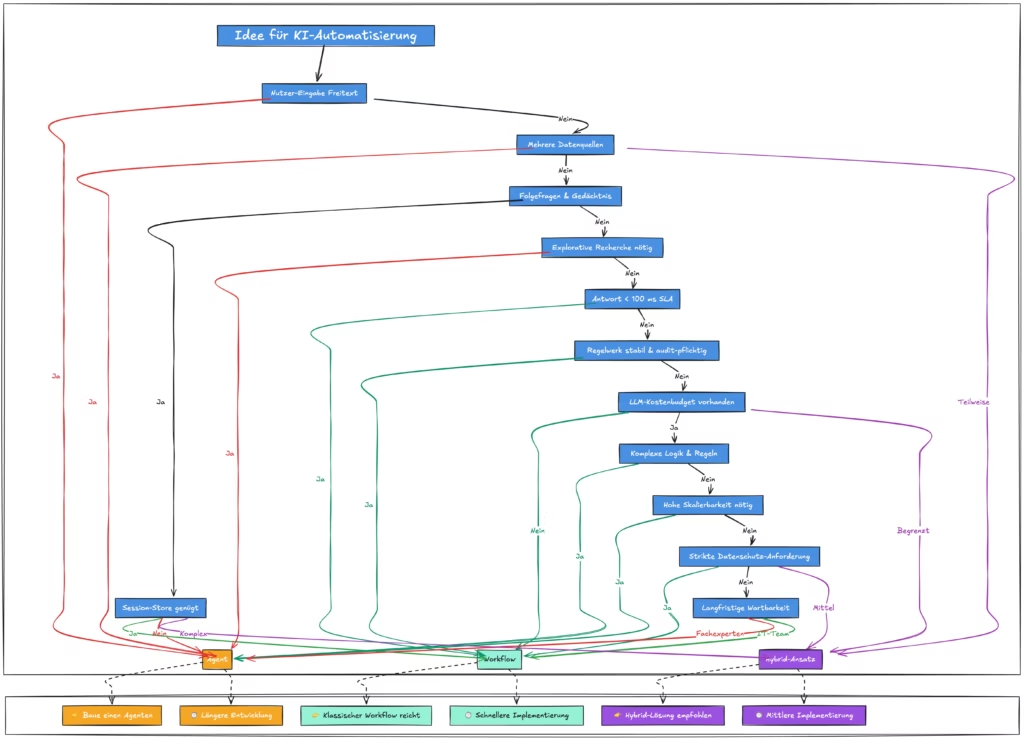

Entscheidungs‑Flow – Gesamtüberblick

Nutze dieses Diagramm, um den gesamten Entscheidungsweg visuell nachzuvollziehen. Es ergänzt das kompakte Diagramm in Kapitel 1 und führt zusätzlich Kosten‑ und Audit‑Checks auf.