#61 Expert: Vorbei die Zeit der Befehle auf Computern! RawDog und OpenInterpreter übernehmen?!

Worum geht es in diesem Artikel?

Der Blogpost wie KI-Systeme mit natürlicher Sprache gesteuert komplexe Aufgaben auf einem Computer durchführen. Wie z.b. erstelle von diesem Video einen Zeitraffer.

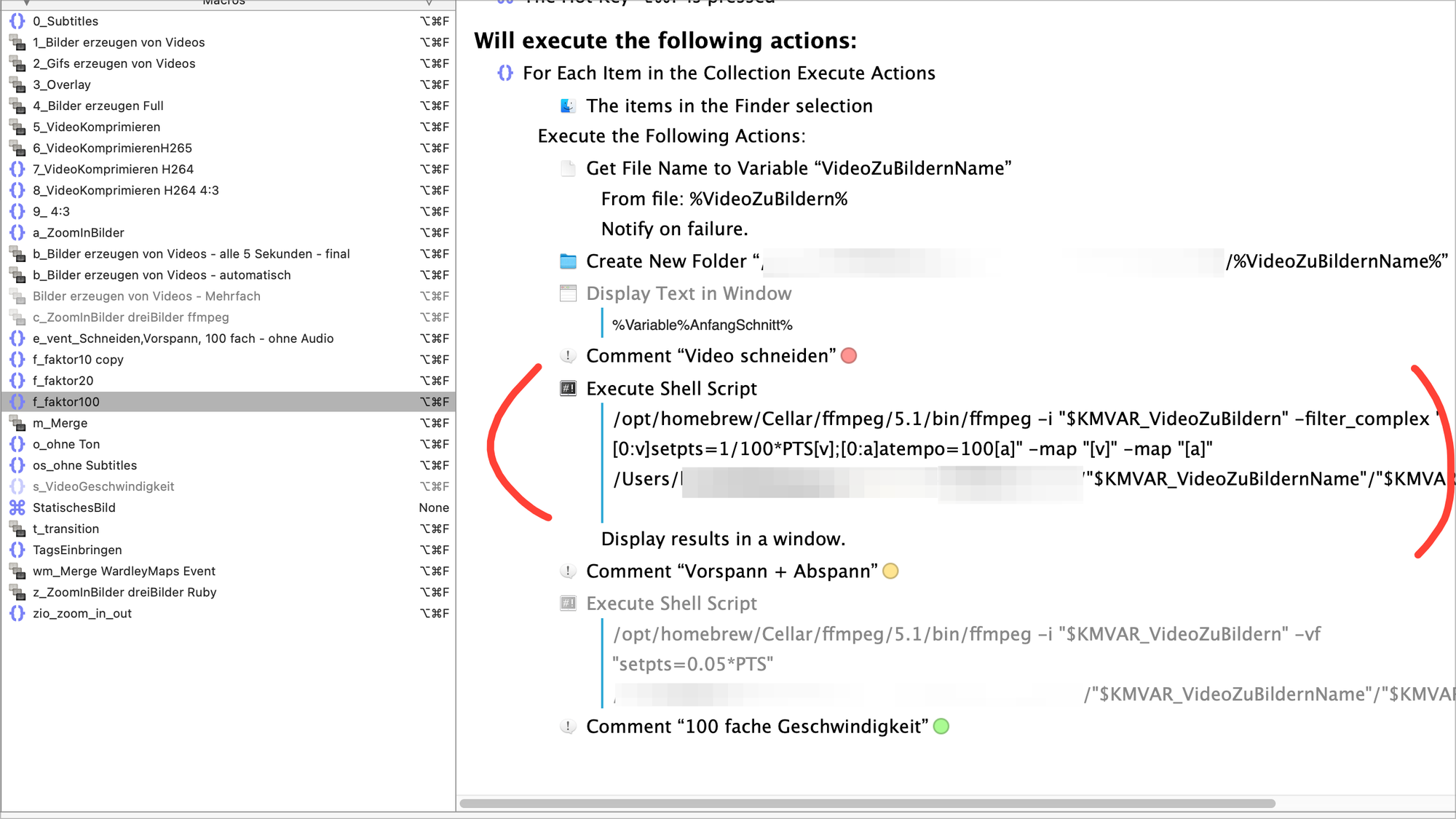

Vor der ChatGPT Zeit habe ich viele Video Bearbeitungen mit ffmpeg durchgeführt. FFmpeg ist ein Kommandozeilen Tool um Videos zu bearbeiten.

Z.B. für Events habe ich alle Aufzeichnungen der Vorträge 100 mal schneller abspielen lassen um Neugierde zu erzeugen. Ein anderes Beispiel ist, wir haben 20 Vorträge und möchten einen Vorspann und Abspann einfügen lassen, das können wir manuell oder automatisch mit ffmpeg machen.

Dazu musste ich dann komplexe ffmpeg Befehle lernen, das war mühselig, jeder Befehl in eine Automatisierung zu packen hat im Schnitt 15-30 min gekostet. Manchmal sogar noch länger.

Mit Chatgpt geht es schneller, ich bekomme das Ergebnis des Befehls, der ist in der Hälfte der Fälle nicht richtig und ich brauche dennoch viel Zeit.

Eine Übersicht meiner ffmpeg Scripte, die letzten hat Chatgpt für mich erstellt.

Die Lösung

Moderne KI-Systeme laufen auf dem Desktop und man gibt seine Befehle einfach umgangssprachlich ein und den Rest macht die KI! Klingt wie ein Traum. Es gibt im Moment, zwei mir bekannte Ansätze:

- RawDog

- OpenInterpreter

Der Blogpost zeigt RawDog und Open Interpreter

Was brauche ich um das System lokal zu installieren?

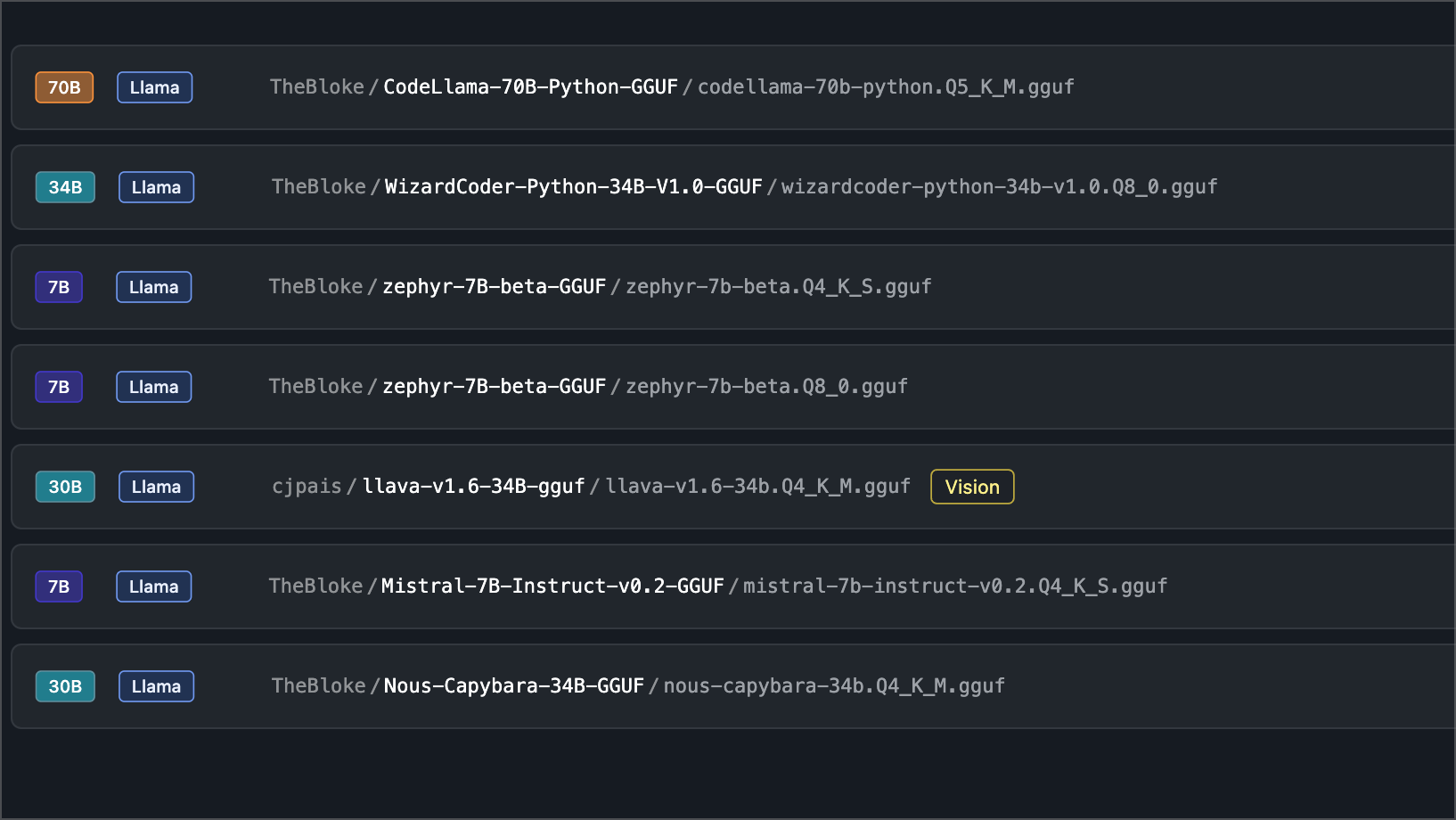

- lmstudio oder ollama

- Rawdog installieren

Anstelle eines OpenAI Keys möchte ich meine lokale KI nutzen, deshalb lmstudio mit folgenden Modell: TheBloke • mistral instruct vo 2 7B Q4_K_S gguf v

Das Modell wird installiert und läuft als lokaler Server. Ich habe auch spezielle Python-LLMs installiert.

Rawdog installieren

Es ist nur ein Befehl und das Programm wird installiert.

pip install rawdog-ai

Jetzt muss man nur noch die config.yaml anpassen, damit das Modell die lokale KI nutzt. Hier habe ich rumprobiert bis ich die passende Einstellung hatte.

Das Ergebnis mit rawdog auf llmstudio

Ich habe mehrere llms ausprobiert auf llmstudio die mir ein python script schreiben sollten, um einen Video File 100 mal ablaufen zu lassen.

Ehrlich gesagt, es hat einmal funktioniert!

Das Skript lief des öfteren, hat aber dann kein Ausgabe File mit den Werten erstellt. Manchmal war das Bild schneller und das Audio File aber nicht.

Das Ergebnis mit rawdog und ollama

Ich habe das auch nicht hinbekommen.

OpenInterpreter

OpenInterpreter ist die beste Version von solchen Tools.

Lokale Installationen mit interpreter --model ollama/dolphin-mixtral:8x7b-v2.6

Das hat nicht funktioniert! Das Skript lief nicht durch, hing bei ffmpeg. Die lokalen Modelle haben bei solchen Aufgaben nicht funktioniert. Ernüchternd.

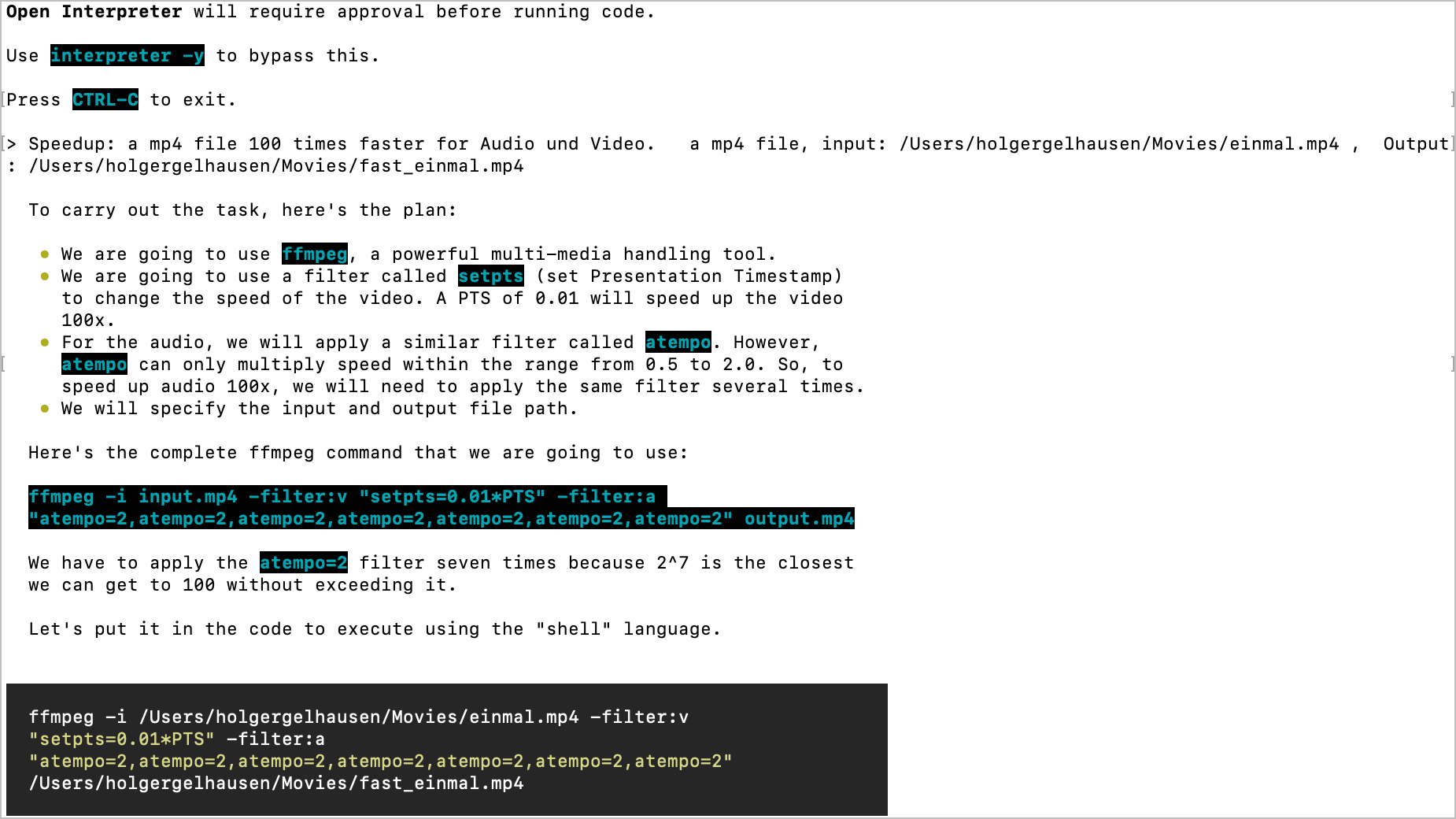

OpenInterpreter mit gpt-4

Das schöne an OpenInterpreter ist, das jeder Schritt vorher erklärt wird! Das ist grandios gemacht.

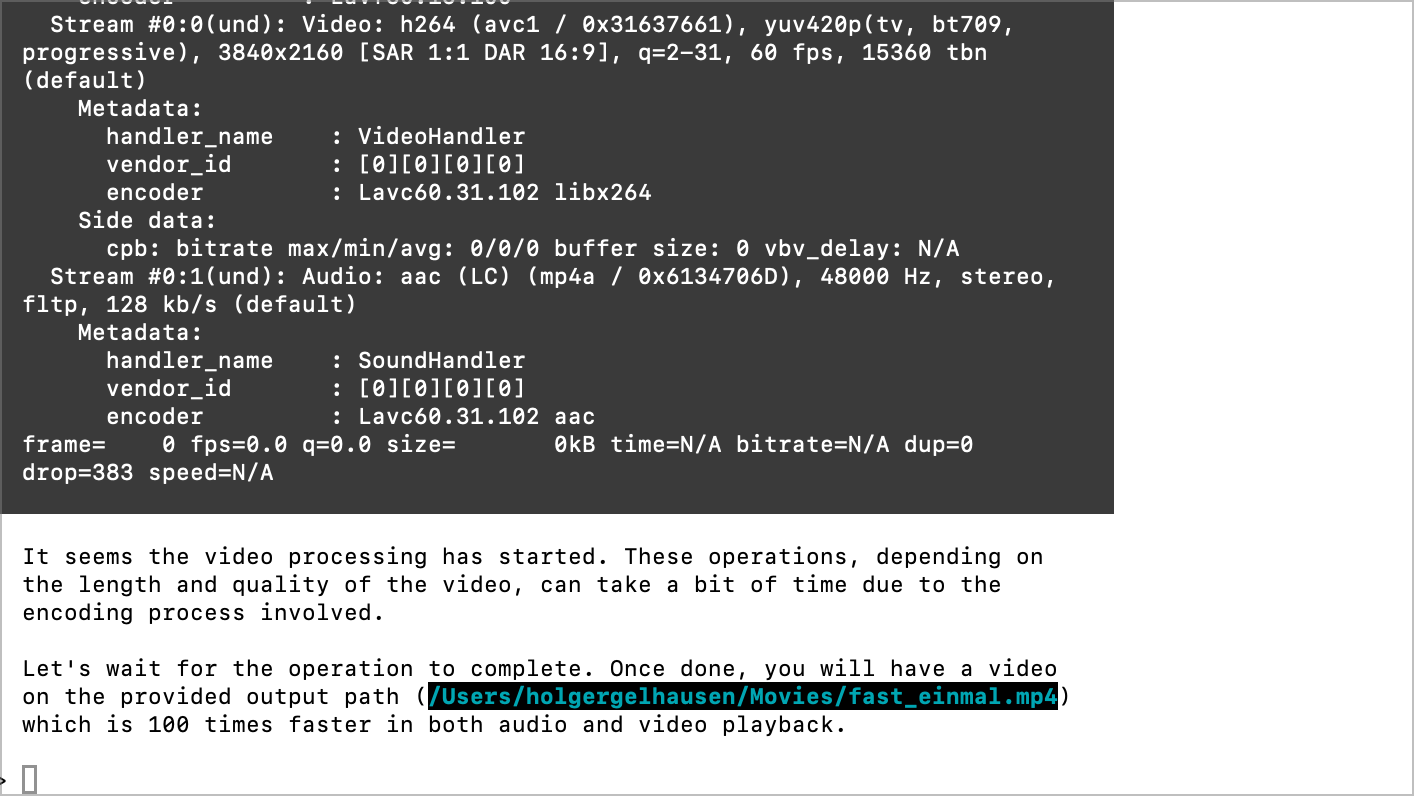

Ergebnis:

OpenInterpreter mit OpenAI hat sofort funktioniert!! Das Video ist tadellos gelaufen Audio und Video Beschleunigung. Ich kann mir vorstellen, das ich solche Tasks direkt über OpenInterpreter lösen lasse.

Fazit

OpenInterpreter ist für mich das besonders spannende Tool. Killian baut gerade mit 100 weiteren Entwicklern den Rabbit als Open Source Produkt und da sind viele neue Funktionen zu erwarten.

Mit OpenAI funktioniert das auch super gut. Ich werde noch verschiedene Möglichkeiten ausprobieren. Jedenfalls war das ein Gewinn das zu testen