#211 Buchgraph aktive Agenten – Wenn Büchern mit dir sprechen

Worum geht es in diesem Artikel?

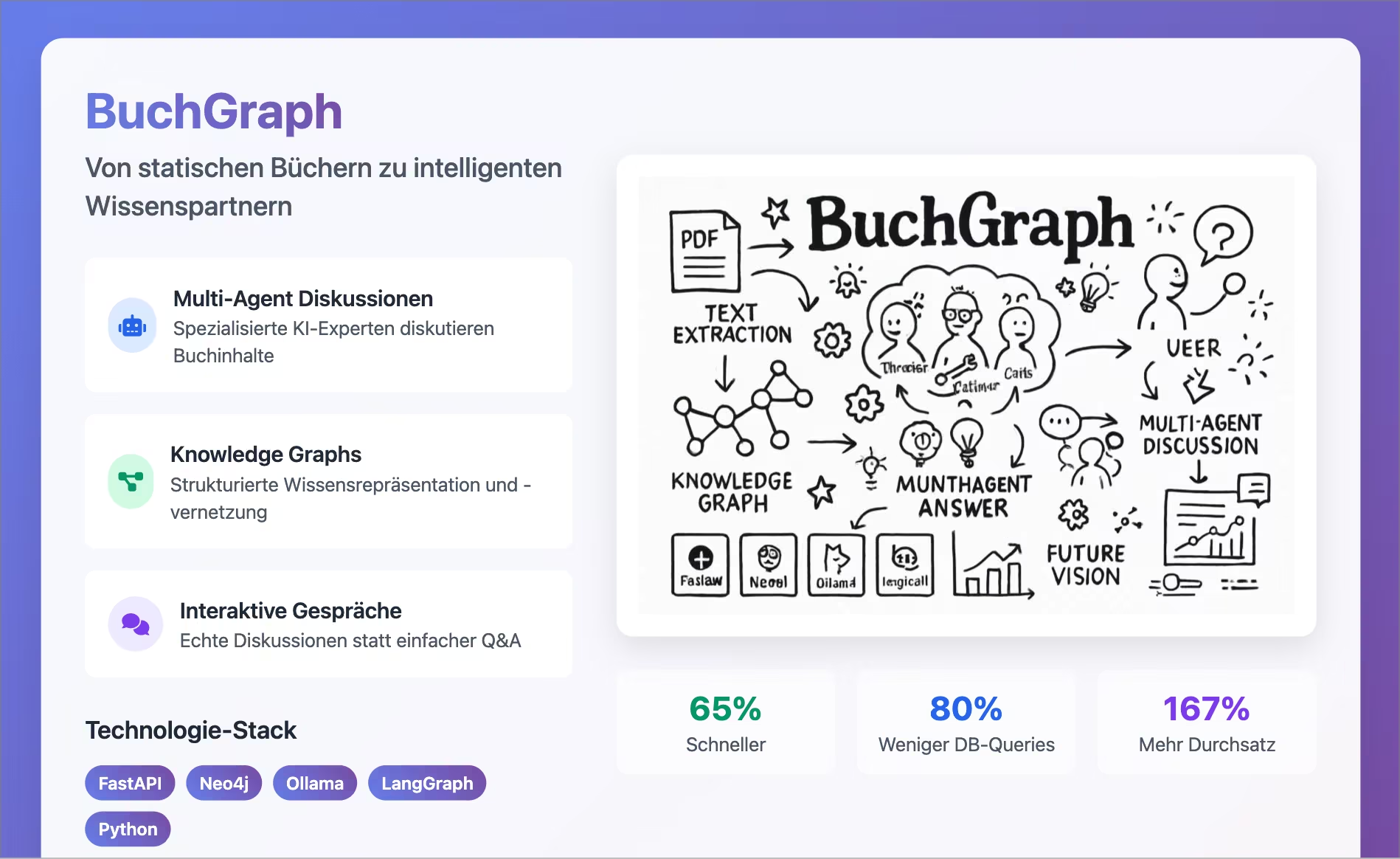

BuchGraph – Vom statischen PDF zum sprechenden Buch

BuchGraph – Vom statischen PDF zum sprechenden Buch

1. Executive Summary (≈1 Min Lektüre)

BuchGraph verwandelt lineare, statische PDFs in interaktive Wissensnetzwerke, die von spezialisierten KI‑Agents live diskutiert werden.

Die wichtigsten Punkte auf einen Blick:

- Knowledge Graph + Multi‑Agent‑System = Gesprächsfähige Bücher

- LangGraph‑Orchestrierung koordiniert Experten‑Agents (Theoretiker, Praktiker, Kritiker, Synthesizer)

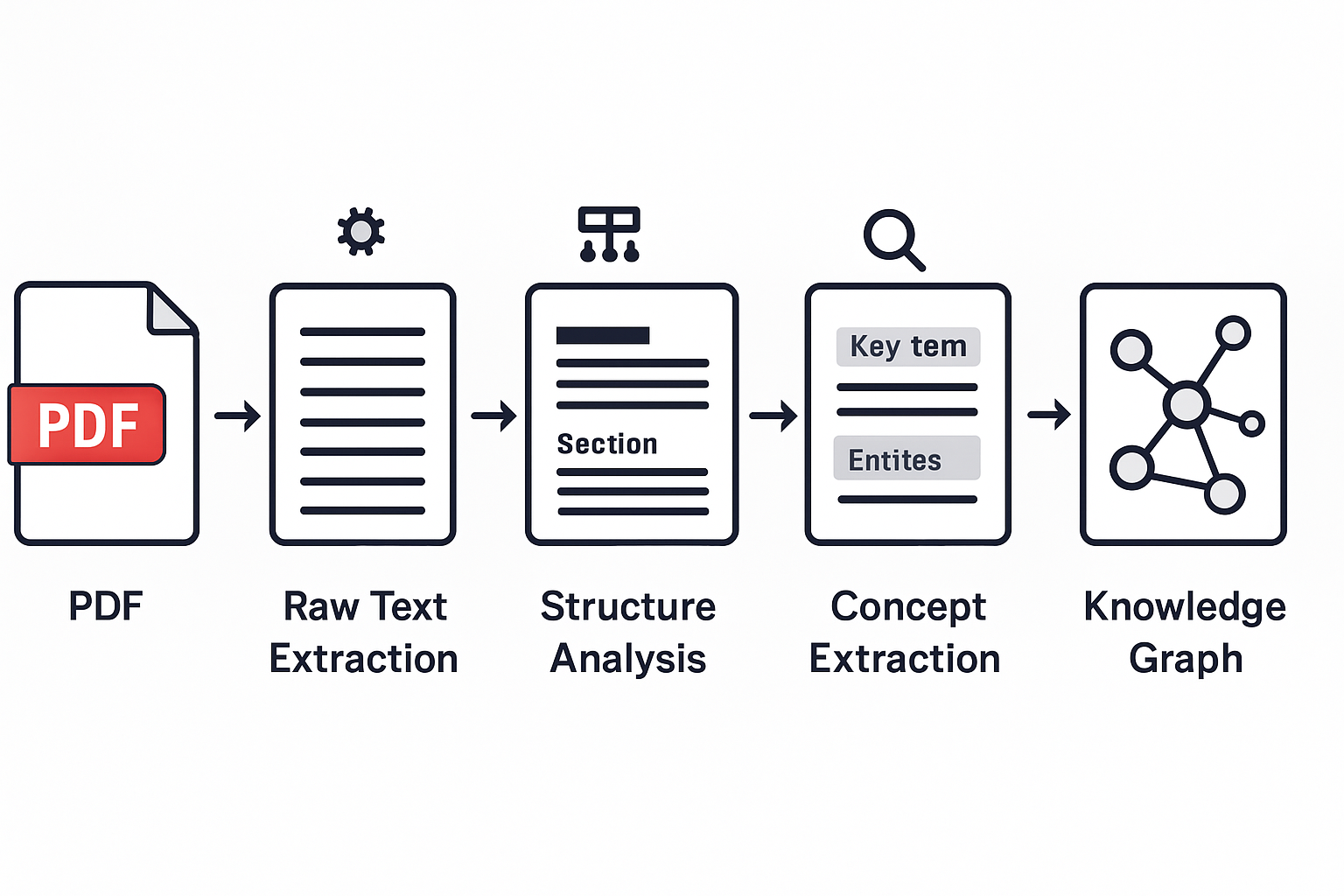

- Pipeline in 5 Stufen: Textextraktion → Strukturanalyse → Konzeptextraktion → Beziehungsextraktion → Graph‑Konstruktion

- Lokale LLMs (Ollama) schützen Daten, Neo4j speichert Beziehungen, FastAPI liefert Streaming‑Antworten

- Performance: < 1 s Antwortzeit dank Caching, Parallelisierung, Async‑Workflow

- Use‑Cases: Verlage, Weiterbildung, Forschung, interne Wissensdatenbanken

- Roadmap: Cross‑Book‑Diskussionen, multimodale Agents, Community‑Annotation, persönliche Wissensassistenten

Mehr Details in den folgenden Kapiteln.

1. BuchGraph: Die faszinierende Reise von statischen PDFs zu intelligenten Buchgesprächen

Eine umfassende Einführung in Multi-Agent-Systeme, Knowledge Graphs und die Zukunft des interaktiven Lesens

2. Einleitung: Die Vision eines sprechenden Buches {#einleitung}

Stellen Sie sich vor, Sie sitzen in einem gemütlichen Café und haben ein faszinierendes Buch vor sich liegen. Plötzlich beginnt das Buch zu sprechen – nicht mit einer Stimme, sondern mit mehreren. Verschiedene Experten, die jeweils ihre Kapitel am besten kennen, diskutieren lebhaft über die Themen, die Sie interessieren. Sie können Fragen stellen, Widersprüche aufdecken lassen und tiefgreifende Analysen anfordern. Das Buch wird lebendig.

Diese Vision mag wie Science Fiction klingen, aber genau das haben wir mit BuchGraph erschaffen. Was als einfaches Projekt zur Analyse von PDF-Dokumenten begann, entwickelte sich zu einem revolutionären System, das die Art und Weise, wie wir mit geschriebenem Wissen interagieren, fundamental verändert.

Von statischen Büchern zu lebendigen Wissenspartnern: Die Vision von BuchGraph

Was ist BuchGraph eigentlich?

BuchGraph ist ein innovatives System, das Bücher in interaktive, intelligente Wissensquellen verwandelt. Statt nur Text zu durchsuchen oder einfache Fragen zu beantworten, ermöglicht es echte Gespräche über Buchinhalte – mit spezialisierten KI-Agents, die wie Experten für verschiedene Kapitel agieren.

Was ist ein KI-Agent?

Ein KI-Agent ist wie ein digitaler Experte, der auf bestimmte Themen spezialisiert ist. Anders als ein einfacher Chatbot hat er spezifisches Wissen, eine eigene „Persönlichkeit“ und kann mit anderen Agents interagieren. Stellen Sie sich vor, Sie hätten für jedes Kapitel eines Buches einen eigenen Professor, der nur über dieses Thema spricht.

Die Grundidee ist verblüffend einfach: Anstatt ein Buch passiv zu lesen, können Sie aktiv mit ihm diskutieren. Sie können fragen: „Wie hängen die Konzepte aus Kapitel 3 mit denen aus Kapitel 7 zusammen?“ oder „Welche praktischen Anwendungen gibt es für die Theorie aus Kapitel 1?“ Das System antwortet nicht nur, sondern lässt verschiedene „Experten“ darüber diskutieren, als würden Sie einer Podiumsdiskussion beiwohnen.

Warum ist das revolutionär?

Traditionelles Lesen ist ein linearer Prozess. Sie beginnen auf Seite 1 und arbeiten sich durch bis zum Ende. Wenn Sie etwas nicht verstehen oder Verbindungen zu anderen Teilen des Buches suchen, müssen Sie selbst blättern, suchen und die Zusammenhänge herstellen.

BuchGraph durchbricht diese Linearität. Es versteht Bücher als das, was sie wirklich sind: komplexe Netzwerke von Ideen, Konzepten und Beziehungen. Ein Konzept aus Kapitel 1 wird in Kapitel 5 erweitert, in Kapitel 8 kritisiert und in Kapitel 12 praktisch angewendet. Diese Verbindungen automatisch zu erkennen und nutzbar zu machen, das ist die wahre Innovation.

Die technische Herausforderung

Hinter dieser scheinbar einfachen Idee verbirgt sich eine enorme technische Komplexität. Das System muss:

- PDFs verstehen: Nicht nur Text extrahieren, sondern Struktur, Kontext und Bedeutung erfassen

- Wissen strukturieren: Aus unstrukturiertem Text ein strukturiertes Wissensnetzwerk aufbauen

- Agents erschaffen: Für jedes Kapitel spezialisierte KI-Experten mit eigenständigen Persönlichkeiten entwickeln

- Diskussionen orchestrieren: Komplexe Gespräche zwischen mehreren Agents koordinieren

- Kontext bewahren: Über lange Diskussionen hinweg den roten Faden behalten

- Performance optimieren: Alles in Echtzeit und mit akzeptabler Geschwindigkeit

Jede dieser Herausforderungen ist für sich genommen bereits komplex. Sie alle elegant zu kombinieren, das war unser Ziel mit BuchGraph.

Ein konkretes Beispiel

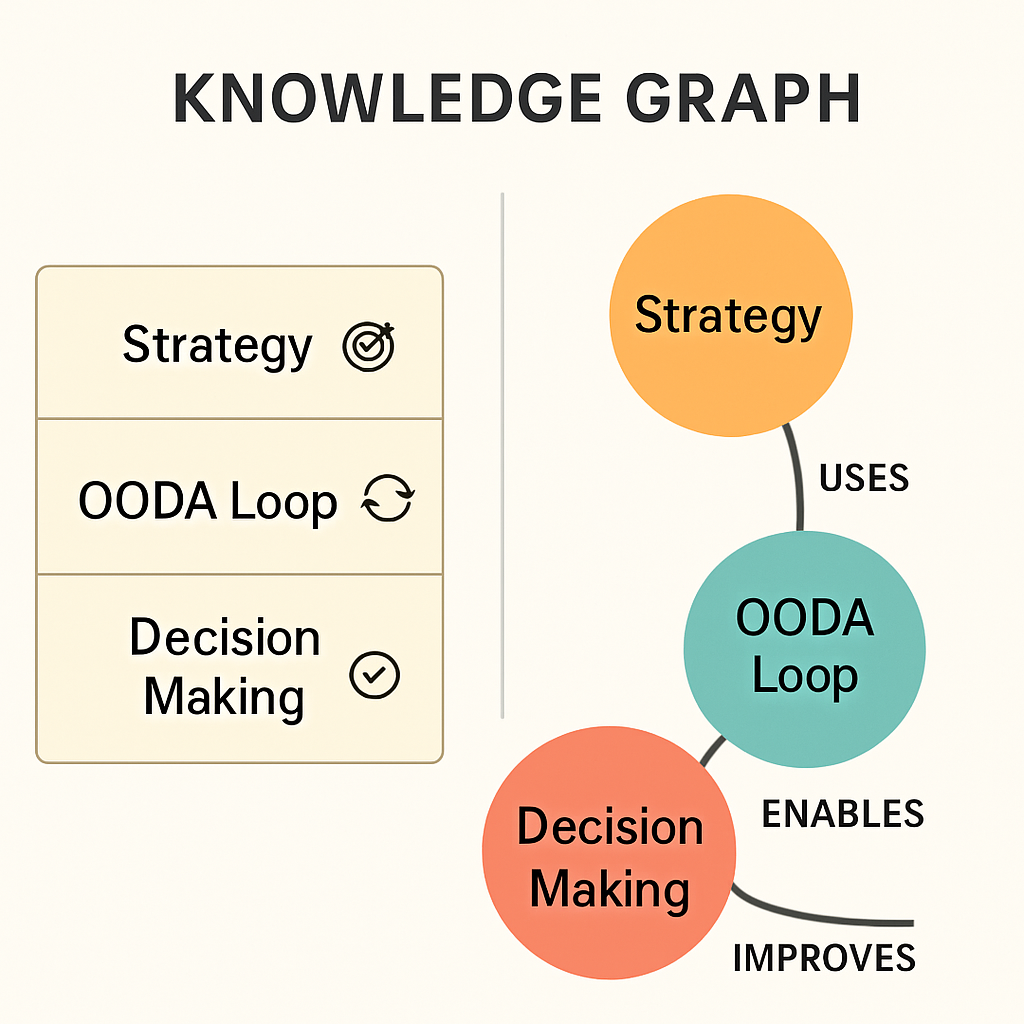

Stellen Sie sich vor, Sie lesen ein Buch über Unternehmensstrategie und fragen: „Wie kann ich die OODA-Loop in einem Startup anwenden?“

In einem traditionellen System würden Sie eine generische Antwort erhalten. In BuchGraph passiert folgendes:

- Der Strategie-Experte (Agent für das OODA-Loop-Kapitel) erklärt die theoretischen Grundlagen

- Der Praxis-Experte (Agent für das Implementierungs-Kapitel) liefert konkrete Umsetzungsschritte

- Der Kritiker (Agent für das Herausforderungen-Kapitel) weist auf mögliche Fallstricke hin

- Der Synthesizer fasst die verschiedenen Perspektiven zu einer kohärenten Antwort zusammen

Das Ergebnis ist nicht nur eine Antwort, sondern eine nuancierte Diskussion, die verschiedene Blickwinkel beleuchtet und Ihnen hilft, das Thema wirklich zu durchdringen.

Die Reise beginnt

In diesem umfassenden Artikel nehmen wir Sie mit auf die Reise von der ersten Idee bis zum funktionierenden System. Sie werden verstehen, wie Knowledge Graphs funktionieren, was Multi-Agent-Systeme so mächtig macht, welche technischen Hürden wir überwinden mussten und wohin diese Technologie in Zukunft führen könnte.

Egal ob Sie Entwickler, Bildungstechnologie-Enthusiast oder einfach nur neugierig auf die Zukunft des Lernens sind – dieser Artikel wird Ihnen neue Perspektiven eröffnen und vielleicht sogar inspirieren, selbst an der nächsten Generation von Wissenssystemen mitzuarbeiten.

3. Die Grundlagen verstehen: Was sind Knowledge Graphs? {#grundlagen-knowledge-graphs}

Bevor wir in die Tiefen von BuchGraph eintauchen, müssen wir die fundamentalen Bausteine verstehen. Der wichtigste davon ist der Knowledge Graph – ein Konzept, das so mächtig wie elegant ist.

Was ist ein Knowledge Graph?

Stellen Sie sich vor, Sie müssten jemandem erklären, wie Ihr Freundeskreis funktioniert. Sie könnten eine Liste erstellen: „Anna, Bob, Clara, David…“ Aber das würde die wichtigsten Informationen auslassen: Wer kennt wen? Wer ist mit wem befreundet? Wer arbeitet zusammen? Wer hat gemeinsame Hobbys?

Ein Knowledge Graph macht genau das für Wissen: Er stellt nicht nur Fakten dar, sondern auch die Beziehungen zwischen ihnen. Anstatt isolierte Informationen zu speichern, erschafft er ein lebendiges Netzwerk von Verbindungen.

Von isolierten Daten zu vernetztem Wissen: Das Grundprinzip von Knowledge Graphs

Die Anatomie eines Knowledge Graphs

Ein Knowledge Graph besteht aus drei grundlegenden Elementen:

1. Knoten (Nodes): Das sind die „Dinge“ in unserem Wissen – Konzepte, Personen, Orte, Ideen. In einem Buch über Strategie könnten das sein: „OODA-Loop“, „Entscheidungsfindung“, „Wettbewerbsvorteil“, „John Boyd“.

2. Kanten (Edges): Das sind die Beziehungen zwischen den Knoten. Sie beschreiben, wie die Dinge miteinander verbunden sind: „wurde entwickelt von“, „ist ein Beispiel für“, „führt zu“, „widerspricht“.

3. Eigenschaften (Properties): Das sind zusätzliche Informationen über Knoten und Kanten. Ein Konzept könnte die Eigenschaft „Wichtigkeit: hoch“ haben, oder eine Beziehung könnte „Stärke: 0.8“ als Eigenschaft besitzen.

Warum Knowledge Graphs so mächtig sind

Der wahre Wert eines Knowledge Graphs liegt nicht in den einzelnen Informationen, sondern in den Mustern und Verbindungen, die entstehen. Hier sind einige Beispiele, was dadurch möglich wird:

Transitive Beziehungen entdecken: Wenn A mit B verbunden ist und B mit C, dann gibt es oft auch eine indirekte Verbindung zwischen A und C. Ein Knowledge Graph kann solche Muster automatisch erkennen.

Ähnlichkeiten finden: Konzepte, die viele gemeinsame Verbindungen haben, sind oft ähnlich oder verwandt. Das System kann automatisch vorschlagen: „Wenn Sie sich für X interessieren, könnte Y auch relevant sein.“

Widersprüche aufdecken: Wenn zwei Konzepte in verschiedenen Kontexten unterschiedlich dargestellt werden, kann das System diese Inkonsistenzen identifizieren und zur Diskussion stellen.

Wissenslücken identifizieren: Bereiche mit wenigen Verbindungen könnten unterentwickelt sein oder Potenzial für neue Erkenntnisse bieten.

Knowledge Graphs in der Praxis

Sie begegnen Knowledge Graphs täglich, ohne es zu merken:

- Google’s Knowledge Graph zeigt Ihnen Informationen über Personen, Orte und Dinge direkt in den Suchergebnissen

- Facebook’s Social Graph versteht die Beziehungen zwischen Menschen und schlägt Freunde vor

- Amazon’s Product Graph empfiehlt Ihnen Produkte basierend auf komplexen Beziehungsmustern

- Wikipedia’s Linked Data verbindet Artikel durch ein riesiges Netzwerk von Referenzen

Der Unterschied zu traditionellen Datenbanken

Traditionelle Datenbanken sind wie gut organisierte Aktenschränke. Sie sind perfekt, um spezifische Informationen schnell zu finden, aber schlecht darin, unerwartete Verbindungen zu entdecken.

Knowledge Graphs sind wie ein lebendiges Gehirn. Sie speichern nicht nur Fakten, sondern auch die Art, wie diese Fakten miteinander in Beziehung stehen. Das macht sie ideal für Anwendungen, die Verständnis und Einsicht erfordern, nicht nur Datenabruf.

Herausforderungen beim Aufbau von Knowledge Graphs

Der Aufbau eines Knowledge Graphs ist keine triviale Aufgabe. Die größten Herausforderungen sind:

Entitätserkennung: Wie erkennt man, dass „John Boyd“, „Colonel Boyd“ und „der Entwickler der OODA-Loop“ alle dieselbe Person bezeichnen?

Beziehungsextraktion: Wie identifiziert man automatisch, dass zwischen „Strategie“ und „OODA-Loop“ eine „verwendet“-Beziehung besteht?

Disambiguierung: Wie unterscheidet man zwischen verschiedenen Bedeutungen desselben Wortes? „Bank“ kann ein Finanzinstitut oder ein Sitzplatz sein.

Qualitätssicherung: Wie stellt man sicher, dass die extrahierten Beziehungen korrekt und relevant sind?

Skalierung: Wie baut man Knowledge Graphs, die Millionen von Konzepten und Beziehungen handhaben können?

Knowledge Graphs für Bücher: Die besondere Herausforderung

Bücher stellen besondere Anforderungen an Knowledge Graphs. Anders als strukturierte Datenquellen wie Wikipedia sind Bücher:

Narrativ strukturiert: Die Information folgt der Logik einer Geschichte oder Argumentation, nicht einer Datenbank-Struktur.

Kontextabhängig: Die Bedeutung von Konzepten entwickelt sich über das Buch hinweg. Ein Begriff in Kapitel 1 kann in Kapitel 10 eine völlig andere Nuance haben.

Implizit vernetzt: Autoren erwähnen Verbindungen oft nicht explizit. Sie setzen voraus, dass Leser die Zusammenhänge selbst herstellen.

Subjektiv gefärbt: Jeder Autor hat eine eigene Perspektive. Was in einem Buch als Fakt dargestellt wird, könnte in einem anderen kontrovers diskutiert werden.

Diese Herausforderungen zu meistern, war einer der Schlüssel zum Erfolg von BuchGraph. Wir mussten Techniken entwickeln, die nicht nur Fakten extrahieren, sondern auch Nuancen, Kontexte und implizite Verbindungen verstehen.

Die Magie der Emergenz

Das Faszinierendste an Knowledge Graphs ist ihre emergente Natur. Wenn Sie genügend Knoten und Kanten haben, entstehen plötzlich Muster und Einsichten, die niemand explizit programmiert hat. Das System beginnt, Verbindungen zu sehen, die selbst Experten überraschen können.

In BuchGraph führte das zu Momenten echter Entdeckung. Das System fand Verbindungen zwischen Konzepten aus verschiedenen Kapiteln, die selbst wir als Entwickler nicht erwartet hatten. Es erkannte Muster in der Argumentation des Autors und konnte Vorhersagen darüber treffen, welche Themen für bestimmte Fragen relevant sein könnten.

Diese emergenten Eigenschaften sind es, die Knowledge Graphs von einfachen Datenstrukturen zu intelligenten Wissenssystemen machen. Sie sind der Grund, warum BuchGraph mehr ist als nur eine ausgeklügelte Suchmaschine – es ist ein System, das Wissen wirklich versteht.

4. Der erste Schritt: Von PDF zu strukturiertem Wissen {#pdf-zu-wissen}

Der Weg von einem statischen PDF-Dokument zu einem lebendigen Knowledge Graph ist wie die Verwandlung von einem Schwarz-Weiß-Foto in einen interaktiven 3D-Film. Jeder Schritt bringt neue Dimensionen des Verständnisses mit sich.

Das PDF-Problem: Mehr als nur Text

Auf den ersten Blick scheint die Extraktion von Text aus PDFs trivial zu sein. Moderne Tools können das problemlos. Aber Text ist nicht gleich Wissen. Ein PDF ist wie ein eingefrorener Moment des Denkens eines Autors – alle Informationen sind da, aber die Struktur, die Beziehungen und der Kontext sind in der linearen Textform versteckt.

Stellen Sie sich vor, Sie bekommen die Einzelteile eines komplexen Puzzles, aber ohne das Bild auf der Schachtel. Sie haben alle Informationen, aber Sie müssen erst verstehen, wie sie zusammengehören. Genau das ist die Herausforderung bei der Transformation von PDFs zu Knowledge Graphs.

Die fünf Stufen der Transformation: Von statischem PDF zu lebendigem Wissensnetzwerk

Stufe 1: Intelligente Textextraktion

Der erste Schritt scheint einfach: Text aus dem PDF extrahieren. Aber hier lauern bereits die ersten Fallstricke. PDFs sind nicht für maschinelle Verarbeitung optimiert – sie sind für menschliche Augen gemacht.

Herausforderung 1: Layout-Chaos

PDFs können Text in Spalten, Tabellen, Fußnoten und Seitenleisten organisieren. Ein naiver Textextraktor würde diese Elemente in der falschen Reihenfolge lesen und dabei den Sinn entstellen.

Herausforderung 2: Formatierung als Information

Überschriften, Aufzählungen, Hervorhebungen – all das trägt Bedeutung. Ein fett gedrucktes Wort ist oft ein wichtiges Konzept. Eine Überschrift strukturiert das Wissen hierarchisch.

Herausforderung 3: Nicht-Text-Elemente

Diagramme, Bilder, Tabellen enthalten oft die wichtigsten Informationen eines Buches. Diese zu ignorieren bedeutet, wertvolles Wissen zu verlieren.

Unsere Lösung kombiniert mehrere Ansätze:

# Vereinfachtes Beispiel der Textextraktion

def extract_structured_text(pdf_path):

# Layout-bewusste Extraktion

text_blocks = extract_with_layout_analysis(pdf_path)

# Formatierung erhalten

formatted_content = preserve_formatting(text_blocks)

# Nicht-Text-Elemente beschreiben

visual_elements = extract_and_describe_visuals(pdf_path)

return combine_content(formatted_content, visual_elements)Stufe 2: Strukturanalyse – Das Skelett des Wissens

Roher Text ist wie ein Haufen Knochen. Um daraus ein Skelett zu machen, müssen wir die Struktur verstehen. Bücher haben eine natürliche Hierarchie: Teile, Kapitel, Abschnitte, Unterabschnitte. Diese Struktur zu erkennen ist entscheidend für alles, was folgt.

Hierarchie-Erkennung: Das System muss verstehen, dass „Kapitel 3: Strategische Planung“ übergeordnet ist zu „3.1 OODA-Loop Grundlagen“ und „3.2 Praktische Anwendung“.

Kontext-Grenzen: Wo endet ein Gedanke und wo beginnt der nächste? Diese Grenzen zu erkennen ist essentiell für die spätere Konzeptextraktion.

Referenz-Auflösung: Wenn der Text sagt „wie in Kapitel 2 erwähnt“, muss das System diese Referenz verstehen und auflösen können.

Stufe 3: Konzeptextraktion – Die Seele des Wissens

Hier wird es richtig interessant. Das System muss aus dem strukturierten Text die wichtigen Konzepte, Entitäten und Ideen extrahieren. Das ist wie das Destillieren von Alkohol – wir wollen die Essenz, nicht die Füllstoffe.

Named Entity Recognition (NER): Erkennung von Personen (John Boyd), Orten (Pentagon), Organisationen (US Air Force), Daten (1976) und anderen spezifischen Entitäten.

Konzept-Identifikation: Abstrakte Ideen wie „strategischer Vorteil“, „Entscheidungsgeschwindigkeit“ oder „Informationsüberlegenheit“ zu erkennen ist schwieriger als konkrete Entitäten.

Wichtigkeits-Bewertung: Nicht alle Konzepte sind gleich wichtig. Das System muss lernen, zwischen zentralen Ideen und Nebenbemerkungen zu unterscheiden.

Kontext-Sensitivität: Das Wort „Loop“ kann in verschiedenen Kontexten verschiedene Bedeutungen haben. In einem Strategiebuch bezieht es sich wahrscheinlich auf die OODA-Loop, in einem Programmierbuch auf Schleifen.

Stufe 4: Beziehungsextraktion – Die Verbindungen knüpfen

Konzepte allein sind wie Inseln. Die wahre Magie entsteht durch die Brücken zwischen ihnen – die Beziehungen. Diese zu extrahieren ist eine der schwierigsten Aufgaben in der Wissensverarbeitung.

Explizite Beziehungen: Manchmal sind Beziehungen klar ausgedrückt: „Die OODA-Loop wurde von John Boyd entwickelt“ oder „Schnelle Entscheidungen führen zu strategischen Vorteilen“.

Implizite Beziehungen: Oft sind Beziehungen nur angedeutet. Wenn zwei Konzepte häufig zusammen erwähnt werden, gibt es wahrscheinlich eine Verbindung zwischen ihnen.

Kausale Beziehungen: „Wenn A, dann B“ – Beziehungen zu erkennen ist besonders wertvoll, aber auch besonders schwierig.

Temporale Beziehungen: „Vor“, „nach“, „während“ – zeitliche Beziehungen helfen beim Verständnis von Prozessen und Entwicklungen.

Stufe 5: Knowledge Graph Konstruktion – Das große Ganze

Im letzten Schritt fügen wir alle Puzzleteile zusammen. Aus Tausenden von Konzepten und Beziehungen entsteht ein kohärentes Wissensnetzwerk.

Entitäts-Auflösung: „John Boyd“, „Colonel Boyd“ und „der Entwickler der OODA-Loop“ müssen als dieselbe Person erkannt werden.

Beziehungs-Validierung: Nicht alle extrahierten Beziehungen sind korrekt. Das System muss lernen, plausible von unplausiblen Verbindungen zu unterscheiden.

Hierarchie-Integration: Die ursprüngliche Buchstruktur muss in den Knowledge Graph integriert werden, damit Agents wissen, aus welchem Kontext ihr Wissen stammt.

Qualitätssicherung: Jeder Knoten und jede Kante bekommt einen Konfidenzwert. Das hilft später bei der Entscheidung, welche Informationen vertrauenswürdig sind.

Die besonderen Herausforderungen von Büchern

Bücher sind keine Wikipedia-Artikel. Sie haben Eigenschaften, die die Wissensextraktion besonders herausfordernd machen:

Narrative Struktur: Informationen werden nicht neutral präsentiert, sondern in eine Geschichte oder Argumentation eingebettet. Das System muss zwischen Fakten und Meinungen unterscheiden können.

Entwickelnde Konzepte: Ein Konzept wird oft über mehrere Kapitel hinweg entwickelt. In Kapitel 1 wird es eingeführt, in Kapitel 3 vertieft, in Kapitel 7 kritisch hinterfragt. Das System muss diese Evolution verstehen.

Implizite Annahmen: Autoren setzen oft Vorwissen voraus. Sie erklären nicht jeden Begriff neu, sondern bauen auf etabliertem Wissen auf.

Subjektive Perspektive: Jeder Autor hat einen eigenen Blickwinkel. Was als Fakt präsentiert wird, könnte in anderen Quellen kontrovers diskutiert werden.

Qualitätskontrolle: Vertrauen schaffen

Ein Knowledge Graph ist nur so gut wie die Qualität seiner Daten. Deshalb haben wir mehrere Kontrollmechanismen eingebaut:

Konfidenz-Scores: Jede extrahierte Information bekommt einen Vertrauenswert. Klar ausgedrückte Fakten haben hohe Scores, interpretierte Beziehungen niedrigere.

Cross-Validation: Informationen, die an mehreren Stellen im Buch erwähnt werden, sind wahrscheinlich wichtiger und korrekter.

Konsistenz-Prüfung: Das System überprüft, ob extrahierte Informationen miteinander konsistent sind.

Human-in-the-Loop: Bei unsicheren Fällen kann das System menschliche Experten um Hilfe bitten.

Das Ergebnis: Ein lebendiger Wissensgraph

Am Ende dieses Prozesses haben wir aus einem statischen PDF ein lebendiges Wissensnetzwerk geschaffen. Dieses Netzwerk:

- Versteht Zusammenhänge: Es weiß nicht nur, dass die OODA-Loop existiert, sondern auch, wie sie mit anderen Konzepten verbunden ist

- Bewahrt Kontext: Es erinnert sich daran, in welchem Kapitel welche Information steht

- Ermöglicht Navigation: Es kann Pfade zwischen entfernten Konzepten finden

- Unterstützt Inferenz: Es kann neue Verbindungen ableiten, die nicht explizit im Text stehen

Dieser Knowledge Graph ist das Fundament für alles, was folgt. Ohne ihn wären unsere Agents nur weitere Chatbots. Mit ihm werden sie zu echten Wissensexperten, die nicht nur Informationen abrufen, sondern Zusammenhänge verstehen und erklären können.

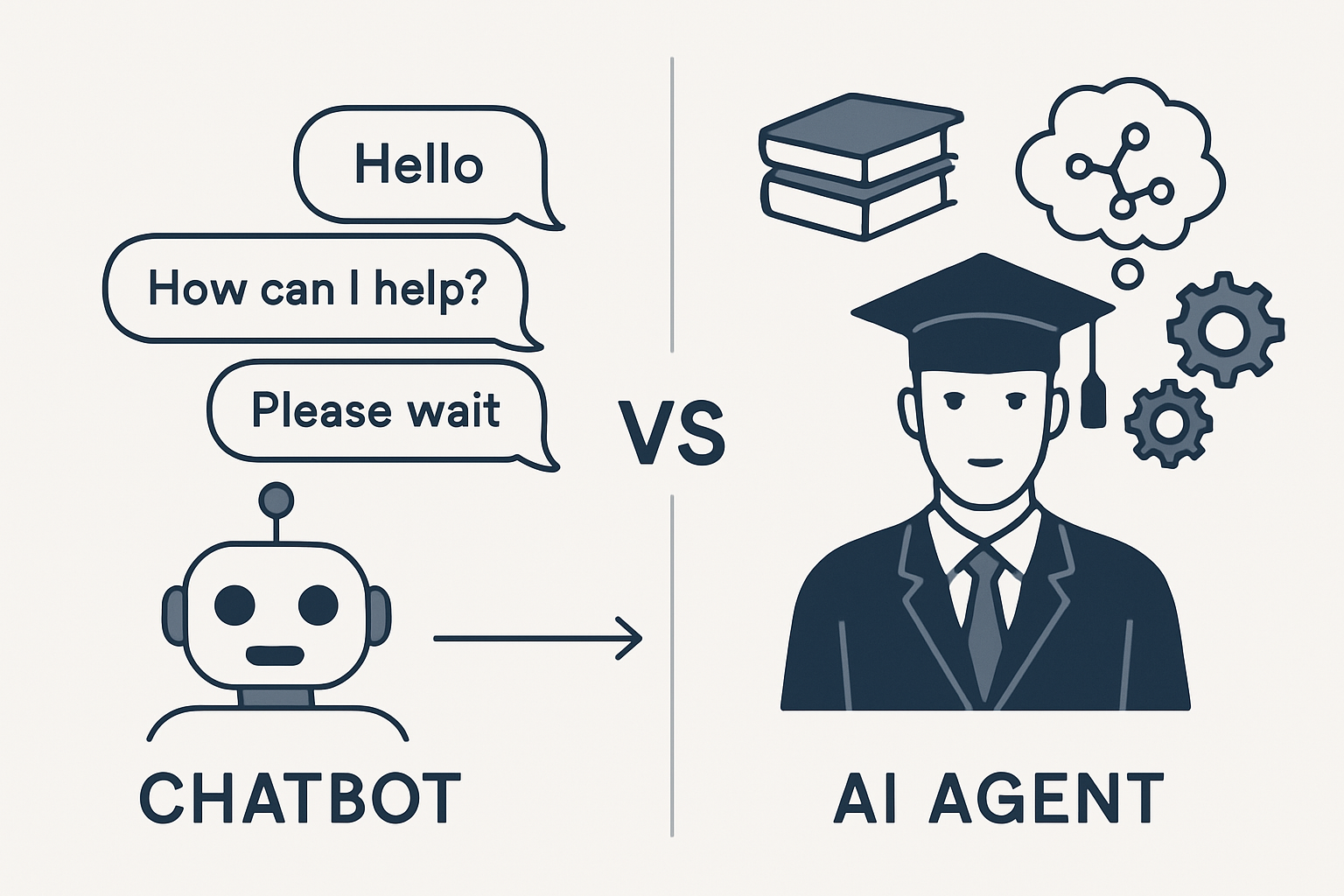

5. Was sind KI-Agents? Eine Einführung {#ki-agents-einfuehrung}

Wenn Knowledge Graphs das Nervensystem von BuchGraph sind, dann sind KI-Agents das Gehirn. Aber was genau ist ein KI-Agent, und warum sind sie so viel mächtiger als herkömmliche Chatbots?

Von Chatbots zu intelligenten Agents

Stellen Sie sich den Unterschied zwischen einem Telefonisten und einem Experten vor. Ein Telefonist kann Ihre Anrufe weiterleiten und einfache Fragen beantworten, aber für komplexe Probleme brauchen Sie einen Spezialisten. Genau so verhält es sich mit Chatbots und KI-Agents.

Traditionelle Chatbots sind wie digitale Telefonisten:

- Sie folgen vorprogrammierten Skripten

- Sie können nur auf spezifische Eingaben reagieren

- Sie haben kein echtes „Verständnis“ für Kontext

- Sie können nicht aus Erfahrungen lernen

- Sie arbeiten isoliert, ohne mit anderen Systemen zu interagieren

KI-Agents sind wie digitale Experten:

- Sie haben spezialisiertes Wissen in bestimmten Bereichen

- Sie können komplexe Probleme analysieren und lösen

- Sie verstehen Kontext und können Schlussfolgerungen ziehen

- Sie können mit anderen Agents zusammenarbeiten

- Sie haben eine „Persönlichkeit“ und einen eigenen Kommunikationsstil

Der Unterschied zwischen reaktiven Chatbots und proaktiven KI-Agents

Die Anatomie eines BuchGraph-Agents

Ein BuchGraph-Agent ist weit mehr als ein spezialisierter Chatbot. Er ist ein digitaler Experte mit mehreren Schichten von Intelligenz:

1. Wissensbasis: Jeder Agent hat Zugang zu einem spezifischen Teil des Knowledge Graphs. Ein Agent für Kapitel 3 kennt nicht nur den Text dieses Kapitels, sondern auch alle Konzepte, Beziehungen und Kontexte, die daraus extrahiert wurden.

2. Persönlichkeit: Agents haben unterschiedliche „Charaktere“. Der Theoretiker erklärt Konzepte akademisch und präzise. Der Praktiker fokussiert auf Anwendungen und Beispiele. Der Kritiker hinterfragt Annahmen und zeigt Schwächen auf.

3. Kommunikationsstil: Jeder Agent hat seinen eigenen Ton. Manche sind formal und professoral, andere locker und zugänglich. Diese Vielfalt macht Diskussionen lebendiger und interessanter.

4. Kontext-Bewusstsein: Agents verstehen nicht nur ihre eigene Expertise, sondern auch, wie sie sich zu anderen Teilen des Buches verhält. Sie können Verbindungen zu anderen Kapiteln herstellen und auf vorherige Diskussionspunkte eingehen.

5. Lernfähigkeit: Durch jede Interaktion werden Agents besser. Sie lernen, welche Antworten hilfreich sind, welche Verbindungen Nutzer interessant finden, und wie sie ihre Kommunikation verbessern können.

Spezialisierung: Warum Experten besser sind als Generalisten

In der realen Welt gehen Sie zum Kardiologen für Herzprobleme und zum Neurologen für Gehirnfragen. Genauso sind spezialisierte Agents effektiver als ein einzelner „Alles-Könner“.

Tiefes vs. breites Wissen: Ein Agent, der sich nur auf ein Kapitel konzentriert, kann viel tiefer in die Materie eintauchen als ein Agent, der das ganze Buch abdecken muss.

Authentische Perspektiven: Verschiedene Kapitel haben oft verschiedene Blickwinkel auf dasselbe Thema. Spezialisierte Agents können diese Nuancen besser vermitteln.

Natürliche Diskussionen: Wenn verschiedene Agents verschiedene Standpunkte vertreten, entstehen natürliche Diskussionen, die dem Nutzer helfen, ein Thema von allen Seiten zu betrachten.

Die Herausforderung der Agent-Erstellung

Einen guten Agent zu erschaffen ist wie einen guten Lehrer auszubilden. Es reicht nicht, ihm Wissen zu geben – er muss auch wissen, wie er es vermittelt.

Wissensauswahl: Welche Informationen sind für diesen Agent relevant? Nicht alles aus einem Kapitel ist gleich wichtig.

Persönlichkeitsentwicklung: Wie soll dieser Agent „klingen“? Welcher Kommunikationsstil passt zum Inhalt und zur Zielgruppe?

Grenzen definieren: Was weiß dieser Agent, und was weiß er nicht? Ehrlichkeit über die eigenen Grenzen ist ein Zeichen von Intelligenz.

Interaktionsfähigkeit: Wie soll der Agent mit anderen Agents und mit Nutzern interagieren? Kooperativ? Herausfordernd? Unterstützend?

Multi-Agent-Systeme: Das Ganze ist mehr als die Summe seiner Teile

Einzelne Agents sind bereits mächtig, aber die wahre Magie entsteht, wenn sie zusammenarbeiten. Multi-Agent-Systeme können Probleme lösen, die für einzelne Agents zu komplex wären.

Arbeitsteilung: Verschiedene Agents können verschiedene Aspekte einer Frage bearbeiten und ihre Erkenntnisse zusammenführen.

Peer Review: Agents können sich gegenseitig korrigieren und ergänzen, was zu qualitativ besseren Antworten führt.

Perspektivenvielfalt: Komplexe Themen haben oft mehrere gültige Sichtweisen. Multi-Agent-Systeme können diese Vielfalt abbilden.

Emergente Intelligenz: Manchmal entstehen durch die Interaktion zwischen Agents Einsichten, die keiner von ihnen allein hätte entwickeln können.

Orchestrierung: Der Dirigent des Agent-Orchesters

Multi-Agent-Systeme brauchen Koordination. Wie ein Dirigent ein Orchester leitet, braucht es ein System, das entscheidet:

- Welche Agents sollen an einer Diskussion teilnehmen?

- In welcher Reihenfolge sollen sie sprechen?

- Wann ist eine Diskussion vollständig?

- Wie werden widersprüchliche Meinungen aufgelöst?

- Wie wird das finale Ergebnis zusammengefasst?

Diese Orchestrierung ist eine der komplexesten Aufgaben in BuchGraph. Sie erfordert nicht nur technische Raffinesse, sondern auch ein tiefes Verständnis dafür, wie menschliche Experten in der realen Welt zusammenarbeiten.

Beispiel: Eine Agent-Diskussion in Aktion

Stellen Sie sich vor, ein Nutzer fragt: „Wie kann die OODA-Loop in der Softwareentwicklung angewendet werden?“

Agent 1 (Theoretiker): „Die OODA-Loop, entwickelt von John Boyd, besteht aus vier Phasen: Observe, Orient, Decide, Act. Das Grundprinzip ist, schneller als der Gegner durch diese Schleife zu kommen…“

Agent 2 (Praktiker): „In der Softwareentwicklung könnte das so aussehen: Observe – Nutzerfeedback sammeln, Orient – Markttrends analysieren, Decide – Features priorisieren, Act – Code entwickeln und deployen…“

Agent 3 (Kritiker): „Aber Vorsicht: Die OODA-Loop stammt aus dem militärischen Kontext. Nicht alle Aspekte lassen sich direkt auf die Softwareentwicklung übertragen. Besonders die ‚Gegner‘-Metapher ist problematisch…“

Agent 4 (Synthesizer): „Alle Punkte sind valid. Die OODA-Loop kann als Framework für agile Entwicklung dienen, aber man sollte sie als Denkwerkzeug verstehen, nicht als starre Methodik…“

Diese Art von nuancierter, multiperspektivischer Diskussion ist es, was BuchGraph von einfachen Q&A-Systemen unterscheidet.

Die Zukunft der Agent-Technologie

KI-Agents stehen erst am Anfang ihrer Entwicklung. In Zukunft könnten sie:

Emotionale Intelligenz entwickeln: Agents könnten lernen, die Stimmung und Bedürfnisse von Nutzern zu erkennen und entsprechend zu reagieren.

Kreativität zeigen: Statt nur vorhandenes Wissen zu vermitteln, könnten Agents neue Ideen und Lösungen generieren.

Langzeit-Beziehungen aufbauen: Agents könnten sich an frühere Gespräche erinnern und personalisierte Lernpfade entwickeln.

Interdisziplinäre Verbindungen herstellen: Agents könnten Wissen aus verschiedenen Büchern und Disziplinen verknüpfen.

Die Agent-Technologie in BuchGraph ist ein Vorgeschmack auf diese Zukunft – eine Zukunft, in der KI nicht nur Informationen liefert, sondern echte Wissenspartner wird.

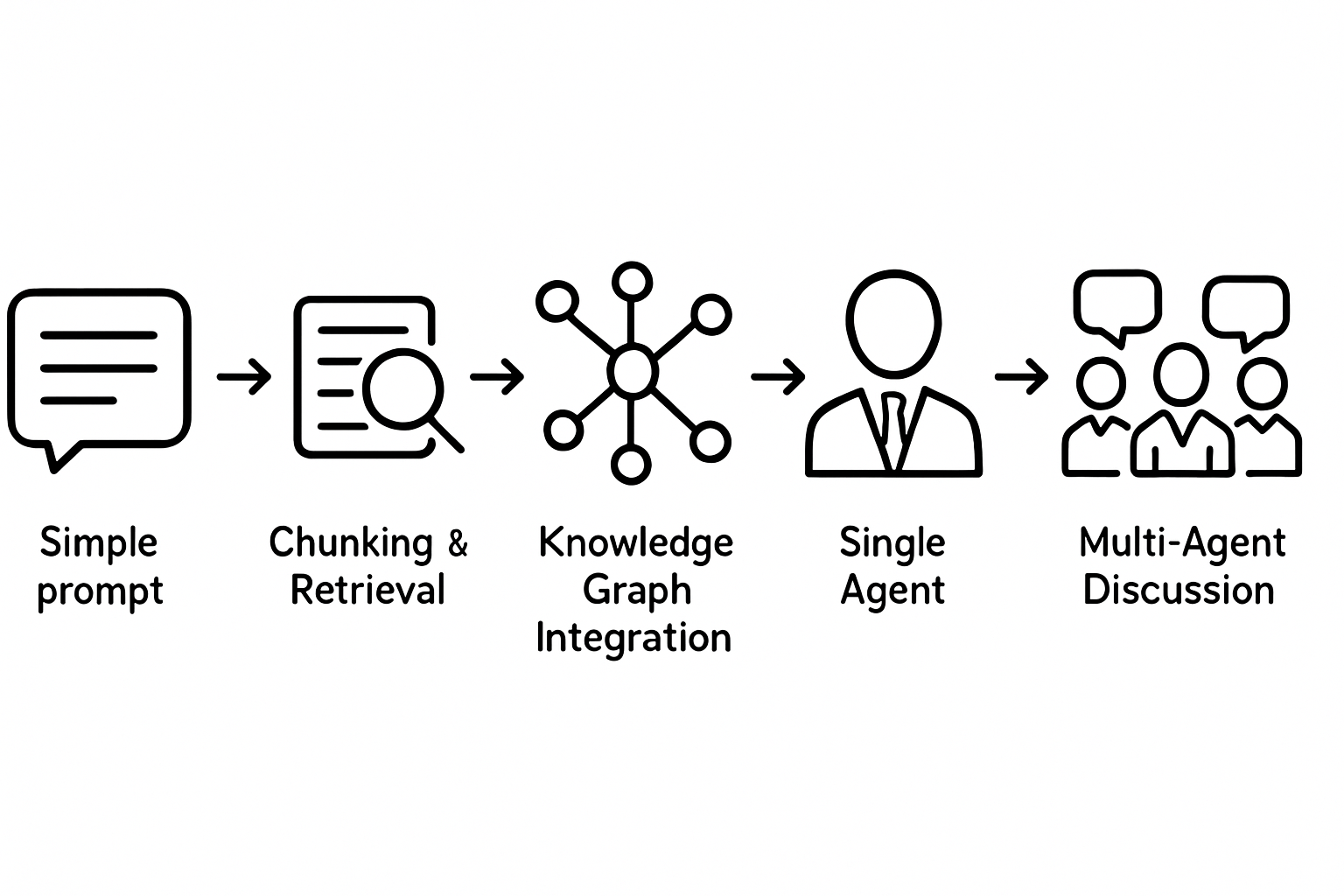

6. Die Evolution: Von einfachen Prompts zu intelligenten Diskussionen {#evolution-agents}

Die Entwicklung von BuchGraph war keine geradlinige Reise. Wie bei jeder Innovation gab es Irrwege, Durchbrüche und Momente der Erkenntnis, die alles veränderten. Die Evolution von einfachen Prompts zu intelligenten Multi-Agent-Diskussionen ist eine Geschichte von technischem Fortschritt und menschlichem Verständnis.

Die ersten Schritte: Naive Ansätze

Am Anfang war die Idee verführerisch einfach: „Lass uns ein LLM mit Buchinhalten füttern und Fragen dazu stellen.“ Dieser Ansatz, so naiv er im Rückblick erscheint, war ein notwendiger erster Schritt.

Version 0.1: Der einfache Prompt

"Hier ist ein Buch über Strategie. Beantworte Fragen dazu: [GESAMTER BUCHTEXT]

Frage: Was ist die OODA-Loop?"Das Ergebnis war ernüchternd. Das LLM produzierte generische Antworten, die zwar korrekt, aber oberflächlich waren. Es fehlte die Tiefe, die Nuance und vor allem die Fähigkeit, verschiedene Perspektiven zu beleuchten.

Die Probleme wurden schnell offensichtlich:

- Kontext-Verlust: Bei langen Texten „vergaß“ das Modell wichtige Details

- Oberflächlichkeit: Antworten waren korrekt, aber nicht tiefgreifend

- Keine Perspektivenvielfalt: Immer nur eine Sichtweise, nie eine Diskussion

- Fehlende Struktur: Das Modell verstand nicht die Hierarchie des Wissens

Version 0.2: Chunking und Retrieval

Der nächste logische Schritt war, das Problem der Kontextlänge zu lösen. Anstatt das gesamte Buch in einen Prompt zu packen, teilten wir es in kleinere Stücke auf und suchten die relevanten Teile für jede Frage.

def answer_question(question, book_chunks):

relevant_chunks = find_relevant_chunks(question, book_chunks)

context = "\n".join(relevant_chunks)

prompt = f"""

Kontext: {context}

Frage: {question}

Antwort:

"""

return llm.generate(prompt)Das war besser, aber immer noch nicht gut genug. Die Antworten waren präziser, aber es fehlte immer noch die Tiefe und die Fähigkeit, Verbindungen zwischen verschiedenen Teilen des Buches herzustellen.

Die fünf Evolutionsstufen von BuchGraph: Von einfachen Prompts zu intelligenten Diskussionen

Version 0.3: Knowledge Graph Integration – Der Durchbruch

Der wahre Durchbruch kam mit der Integration des Knowledge Graphs. Plötzlich verstand das System nicht nur isolierte Textfragmente, sondern die Beziehungen zwischen Konzepten.

def enhanced_answer(question, knowledge_graph):

# Finde relevante Konzepte

relevant_concepts = kg.find_concepts(question)

# Erkunde Beziehungen

related_concepts = kg.explore_relationships(relevant_concepts)

# Baue reichhaltigen Kontext

rich_context = kg.build_context(relevant_concepts, related_concepts)

# Generiere informierte Antwort

return llm.generate_with_context(question, rich_context)Jetzt konnten wir Fragen beantworten wie: „Wie hängt die OODA-Loop mit den Konzepten aus Kapitel 7 zusammen?“ Das System verstand die Verbindungen und konnte sie erklären.

Die Verbesserungen waren dramatisch:

- Tiefere Einsichten: Das System konnte Verbindungen erkennen, die nicht explizit im Text standen

- Kontextuelle Antworten: Jede Antwort war in das größere Wissensnetzwerk eingebettet

- Bessere Relevanz: Durch das Verständnis von Beziehungen wurden Antworten präziser

- Entdeckung neuer Verbindungen: Das System fand oft überraschende, aber sinnvolle Zusammenhänge

Version 0.4: Der erste Agent – Spezialisierung bringt Tiefe

Der nächste Evolutionsschritt war die Erkenntnis, dass Spezialisierung zu besseren Ergebnissen führt. Anstatt ein System zu haben, das über alles spricht, erschufen wir den ersten spezialisierten Agent.

Der Kapitel-Experte war geboren:

- Tiefes Wissen über ein spezifisches Kapitel

- Verständnis für den Kontext und die Argumentation des Autors

- Fähigkeit, komplexe Konzepte zu erklären

- Bewusstsein für die Grenzen des eigenen Wissens

class ChapterAgent:

def __init__(self, chapter_id, knowledge_subset):

self.chapter_id = chapter_id

self.knowledge = knowledge_subset

self.personality = self.develop_personality()

def answer(self, question):

# Prüfe Relevanz für dieses Kapitel

if not self.is_relevant(question):

return "Das liegt außerhalb meiner Expertise..."

# Generiere spezialisierte Antwort

return self.generate_expert_response(question)Die Ergebnisse waren beeindruckend. Der Agent konnte nicht nur Fragen beantworten, sondern auch erklären, warum bestimmte Konzepte wichtig sind, wie sie sich zu anderen Ideen verhalten, und sogar Kritik an den Ansätzen des Autors äußern.

Version 1.0: Multi-Agent-Diskussionen – Die Revolution

Der finale Evolutionsschritt war der Sprung von einem Agent zu mehreren Agents, die miteinander diskutieren können. Das war der Moment, in dem BuchGraph von einem cleveren Q&A-System zu etwas wirklich Revolutionärem wurde.

Die Idee war einfach, aber mächtig: Wenn verschiedene Experten verschiedene Perspektiven haben, warum lassen wir sie nicht miteinander diskutieren?

class DiscussionOrchestrator:

def orchestrate_discussion(self, question, agents):

discussion = []

for round in range(max_rounds):

for agent in agents:

if agent.wants_to_contribute(question, discussion):

contribution = agent.contribute(question, discussion)

discussion.append(contribution)

if self.is_discussion_complete(discussion):

break

return self.synthesize_discussion(discussion)Was dabei herauskam, übertraf alle Erwartungen:

Nuancierte Perspektiven: Verschiedene Agents brachten verschiedene Blickwinkel ein. Der Theoretiker erklärte die Grundlagen, der Praktiker zeigte Anwendungen, der Kritiker wies auf Probleme hin.

Natürliche Diskussionsflüsse: Agents bauten aufeinander auf, widersprachen sich, ergänzten sich – genau wie echte Experten in einer Diskussion.

Emergente Einsichten: Manchmal entstanden durch die Interaktion zwischen Agents neue Erkenntnisse, die keiner von ihnen allein entwickelt hätte.

Selbstkorrektur: Wenn ein Agent etwas Falsches sagte, korrigierten ihn andere Agents. Das System wurde selbstregulierend.

Die technischen Herausforderungen der Evolution

Jeder Evolutionsschritt brachte neue technische Herausforderungen mit sich:

Prompt Engineering: Wie formuliert man Prompts, die konsistent gute Ergebnisse liefern? Das war eine Kunst für sich, die viel Experimentieren erforderte.

Kontext-Management: Wie behält man bei langen Diskussionen den Überblick? Wie entscheidet man, welche Informationen wichtig genug sind, um im Kontext zu bleiben?

Agent-Koordination: Wie verhindert man, dass Agents sich endlos wiederholen oder in Schleifen geraten? Wie stellt man sicher, dass jeder Agent seinen Beitrag leisten kann?

Qualitätskontrolle: Wie erkennt man, wenn ein Agent Unsinn redet? Wie stellt man sicher, dass Diskussionen produktiv bleiben?

Performance: Wie macht man das alles schnell genug für eine gute Nutzererfahrung? Multi-Agent-Diskussionen können sehr ressourcenintensiv sein.

Die Lektionen der Evolution

1. Iteration ist der Schlüssel: Kein System ist beim ersten Versuch perfekt. Jede Version von BuchGraph war ein Schritt auf dem Weg zum Ziel.

2. Spezialisierung schlägt Generalisierung: Ein Experte für ein Thema ist besser als ein Generalist für alles.

3. Emergenz ist mächtig: Wenn man die richtigen Komponenten richtig kombiniert, entstehen Fähigkeiten, die man nicht explizit programmiert hat.

4. Nutzer-Feedback ist unbezahlbar: Jede Evolutionsstufe wurde durch echtes Nutzer-Feedback getrieben.

5. Technische Eleganz ist weniger wichtig als praktischer Nutzen: Die beste Lösung ist die, die für echte Nutzer echte Probleme löst.

Der Weg nach vorn

Die Evolution von BuchGraph ist noch nicht abgeschlossen. Aktuelle Entwicklungen zielen auf:

Emotionale Intelligenz: Agents, die die Stimmung und Bedürfnisse von Nutzern erkennen können.

Kreativität: Agents, die nicht nur vorhandenes Wissen vermitteln, sondern neue Ideen generieren.

Langzeit-Gedächtnis: Agents, die sich an frühere Gespräche erinnern und darauf aufbauen können.

Cross-Book-Diskussionen: Agents aus verschiedenen Büchern, die miteinander diskutieren und Wissen verknüpfen.

Die Reise von einfachen Prompts zu intelligenten Diskussionen zeigt, wie schnell sich KI-Technologie entwickelt. Was heute unmöglich erscheint, könnte morgen Standard sein. BuchGraph ist ein Beispiel dafür, was passiert, wenn man bereit ist, zu experimentieren, zu iterieren und von Fehlern zu lernen.

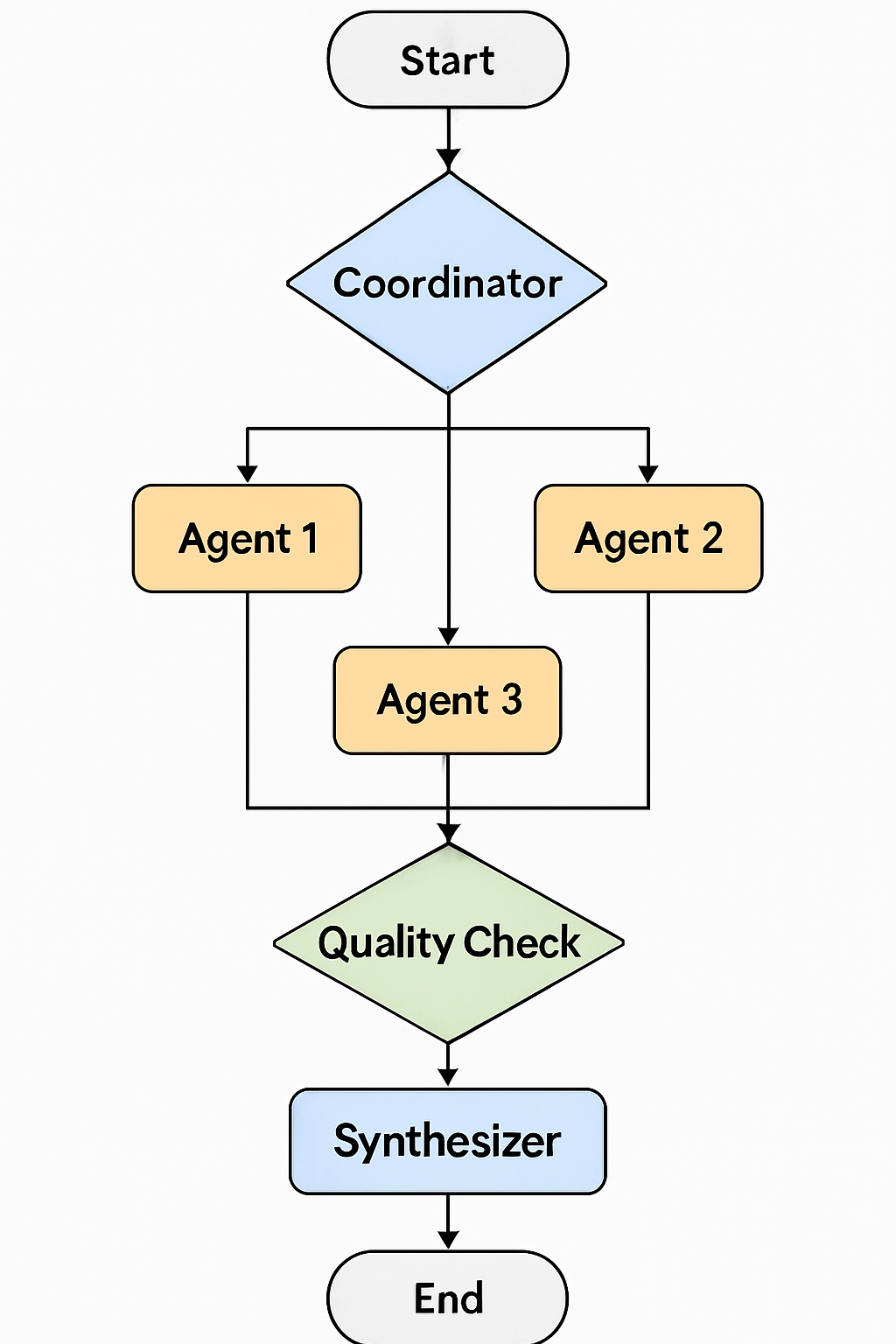

7. LangGraph verstehen: Orchestrierung von Agent-Gesprächen {#langgraph-verstehen}

Wenn Sie schon einmal versucht haben, eine Diskussion zwischen mehreren Experten zu moderieren, wissen Sie, wie komplex das sein kann. Wer spricht wann? Wie stellt man sicher, dass alle zu Wort kommen? Wie verhindert man, dass die Diskussion im Kreis läuft? Genau diese Herausforderungen stellen sich auch bei Multi-Agent-Systemen – und hier kommt LangGraph ins Spiel.

Was ist LangGraph?

LangGraph ist ein Framework für die Orchestrierung komplexer KI-Workflows. Stellen Sie es sich vor wie einen intelligenten Dirigenten, der ein Orchester aus KI-Agents leitet. Es definiert nicht nur, wer wann spricht, sondern auch, wie die verschiedenen Teile zusammenarbeiten, um ein harmonisches Gesamtergebnis zu erzeugen.

Die Grundidee ist elegant: Anstatt lineare Prompt-Ketten zu verwenden, modelliert LangGraph Workflows als Graphen. Jeder Knoten im Graph ist eine Aktion (wie „Agent A antwortet“ oder „Prüfe Qualität“), und die Kanten definieren, unter welchen Bedingungen von einem Knoten zum nächsten gewechselt wird.

Ein typischer LangGraph-Workflow für Multi-Agent-Diskussionen in BuchGraph

Warum traditionelle Ansätze nicht ausreichen

Bevor LangGraph gab es hauptsächlich zwei Ansätze für KI-Workflows:

1. Lineare Ketten: Eine Aktion folgt der anderen in fester Reihenfolge. Das ist einfach, aber unflexibel. Was passiert, wenn Agent A nichts Sinnvolles beitragen kann? Die Kette läuft trotzdem weiter.

2. Regelbasierte Systeme: Komplexe If-Then-Logik bestimmt den Ablauf. Das ist flexibel, aber schnell unübersichtlich und schwer zu debuggen.

LangGraph bietet einen dritten Weg: Workflows als Graphen zu modellieren, die sowohl flexibel als auch verständlich sind.

Die Anatomie eines LangGraph-Workflows

Ein LangGraph-Workflow besteht aus mehreren Komponenten:

Nodes (Knoten): Das sind die Aktionen in Ihrem Workflow. In BuchGraph sind das typischerweise:

- Agent-Antworten

- Koordinations-Entscheidungen

- Qualitätsprüfungen

- Synthese-Schritte

Edges (Kanten): Das sind die Verbindungen zwischen Knoten. Sie definieren, unter welchen Bedingungen von einem Schritt zum nächsten gewechselt wird.

State (Zustand): Das ist der „Speicher“ des Workflows. Hier werden alle Informationen gespeichert, die zwischen den Schritten geteilt werden müssen.

Conditional Logic (Bedingte Logik): Das sind die Entscheidungsregeln, die bestimmen, welcher Pfad durch den Graph genommen wird.

Ein konkretes Beispiel: BuchGraph-Diskussion

Lassen Sie uns einen typischen BuchGraph-Workflow Schritt für Schritt durchgehen:

1. Start: Eine Nutzeranfrage kommt herein: „Wie kann die OODA-Loop in Startups angewendet werden?“

2. Coordinator: Der Koordinator analysiert die Frage und entscheidet:

- Welche Agents sind relevant? (Strategie-Agent, Praxis-Agent, Kritik-Agent)

- In welcher Reihenfolge sollen sie sprechen?

- Wie viele Diskussionsrunden sind nötig?

3. Agent-Phase: Die ausgewählten Agents tragen bei:

- Strategie-Agent erklärt die theoretischen Grundlagen

- Praxis-Agent zeigt konkrete Anwendungen

- Kritik-Agent weist auf mögliche Probleme hin

4. Quality Check: Das System prüft:

- Sind die Antworten relevant?

- Widersprechen sie sich?

- Fehlen wichtige Perspektiven?

5. Iteration oder Synthese: Je nach Qualitätsprüfung:

- Weitere Diskussionsrunde, wenn nötig

- Oder Synthese zu einer finalen Antwort

6. End: Die finale, synthetisierte Antwort wird an den Nutzer gesendet.

Die Vorteile von LangGraph für BuchGraph

Flexibilität: Nicht jede Diskussion läuft gleich ab. Manchmal reicht ein Agent, manchmal braucht es fünf. LangGraph passt sich dynamisch an.

Transparenz: Der Workflow ist als Graph visualisierbar. Man kann genau sehen, welche Entscheidungen getroffen wurden und warum.

Debugging: Wenn etwas schiefgeht, kann man genau sehen, an welchem Punkt im Graph das Problem aufgetreten ist.

Erweiterbarkeit: Neue Agents oder Logik-Komponenten lassen sich einfach als neue Knoten hinzufügen.

Parallelisierung: Unabhängige Agents können parallel arbeiten, was die Performance verbessert.

Herausforderungen bei der Implementierung

State Management: Der Zustand des Workflows kann schnell komplex werden. Welche Informationen müssen zwischen den Schritten geteilt werden? Wie verhindert man, dass der State zu groß wird?

Endlos-Schleifen: Was passiert, wenn Agents sich endlos widersprechen? Wie erkennt man, wann eine Diskussion produktiv ist und wann sie im Kreis läuft?

Performance: Multi-Agent-Workflows können langsam werden. Wie optimiert man die Ausführung, ohne die Qualität zu beeinträchtigen?

Fehlerbehandlung: Was passiert, wenn ein Agent einen Fehler macht oder nicht antwortet? Wie macht der Workflow trotzdem weiter?

Erweiterte LangGraph-Patterns in BuchGraph

Conditional Routing: Basierend auf dem Inhalt der Nutzeranfrage werden verschiedene Workflow-Pfade gewählt. Theoretische Fragen führen zu anderen Agents als praktische Fragen.

Human-in-the-Loop: Bei unsicheren Entscheidungen kann der Workflow pausieren und menschliche Eingabe anfordern.

Retry Logic: Wenn ein Agent eine schlechte Antwort gibt, kann der Workflow automatisch einen Retry mit verbessertem Kontext versuchen.

Dynamic Agent Selection: Die Auswahl der Agents kann sich während der Diskussion ändern, basierend auf dem, was bereits gesagt wurde.

Code-Beispiel: Vereinfachter BuchGraph-Workflow

from langgraph.graph import StateGraph

def create_discussion_workflow():

workflow = StateGraph(DiscussionState)

# Knoten hinzufügen

workflow.add_node("coordinator", coordinate_discussion)

workflow.add_node("agent_1", agent_1_respond)

workflow.add_node("agent_2", agent_2_respond)

workflow.add_node("quality_check", check_quality)

workflow.add_node("synthesizer", synthesize_responses)

# Workflow-Logik definieren

workflow.set_entry_point("coordinator")

workflow.add_conditional_edges(

"coordinator",

decide_next_step,

{

"agent_1": "agent_1",

"agent_2": "agent_2",

"synthesize": "synthesizer"

}

)

workflow.add_edge("agent_1", "quality_check")

workflow.add_edge("agent_2", "quality_check")

workflow.add_conditional_edges(

"quality_check",

evaluate_quality,

{

"continue": "coordinator",

"synthesize": "synthesizer"

}

)

return workflow.compile()Die Zukunft von LangGraph in BuchGraph

LangGraph entwickelt sich ständig weiter, und mit ihm die Möglichkeiten für BuchGraph:

Adaptive Workflows: Workflows, die sich basierend auf Nutzer-Feedback selbst optimieren.

Nested Workflows: Komplexe Diskussionen, die aus mehreren Sub-Diskussionen bestehen.

Real-time Collaboration: Mehrere Nutzer können gleichzeitig an einer Diskussion teilnehmen.

Cross-Book Workflows: Agents aus verschiedenen Büchern können in einem gemeinsamen Workflow zusammenarbeiten.

LangGraph ist mehr als nur ein technisches Tool – es ist die Grundlage, die komplexe, intelligente Interaktionen zwischen KI-Agents ermöglicht. Ohne LangGraph wäre BuchGraph nur eine Sammlung von Chatbots. Mit LangGraph wird es zu einem orchestrierten Ensemble von Experten, die zusammenarbeiten, um tiefgreifende Einsichten zu liefern.

8. Die größten technischen Herausforderungen {#technische-herausforderungen}

Jedes ambitionierte Projekt bringt unerwartete Herausforderungen mit sich. Bei BuchGraph waren es nicht die offensichtlichen Probleme, die uns am meisten Kopfzerbrechen bereiteten, sondern die subtilen, komplexen Fragen, die erst auftauchten, als das System zu funktionieren begann. Hier sind die größten technischen Hürden, die wir überwinden mussten.

Herausforderung 1: Das Kontext-Dilemma

Das Problem: LLMs haben begrenzte Kontextfenster. Selbst die modernsten Modelle können nur eine bestimmte Menge an Text auf einmal verarbeiten. Aber Bücher sind lang, und Diskussionen zwischen Agents können sehr ausführlich werden.

Warum das kritisch war: Stellen Sie sich vor, Sie führen ein Gespräch mit jemandem, der alle fünf Minuten vergisst, worüber Sie gerade gesprochen haben. Genau das passierte unseren frühen Agents. Sie verloren den Faden, wiederholten sich oder widersprachen ihren eigenen früheren Aussagen.

Die naive Lösung: Einfach alles in den Kontext packen. Das funktionierte bei kurzen Texten, führte aber schnell zu Problemen:

- Performance-Einbrüche bei langen Kontexten

- Hohe Kosten bei API-basierten Modellen

- „Lost in the middle“-Problem: Wichtige Informationen in der Mitte langer Kontexte wurden übersehen

Unsere Lösung: Ein intelligentes Kontext-Management-System:

class IntelligentContextManager:

def __init__(self):

self.context_window = 4000 # Token-Limit

self.importance_scorer = ImportanceScorer()

self.summarizer = ContextSummarizer()

def manage_context(self, current_context, new_information):

# Bewerte Wichtigkeit aller Kontext-Elemente

scored_elements = self.importance_scorer.score_all(current_context)

# Wenn neuer Kontext zu groß wird

if self.would_exceed_limit(current_context, new_information):

# Entferne unwichtige Elemente

trimmed_context = self.trim_context(scored_elements)

# Fasse entfernte Elemente zusammen

summary = self.summarizer.summarize_removed(trimmed_context)

return self.combine_context(trimmed_context, summary, new_information)

return current_context + new_informationDie Lektionen:

- Nicht alle Informationen sind gleich wichtig

- Zusammenfassungen können oft wichtige Details bewahren

- Adaptive Strategien funktionieren besser als starre Regeln

Herausforderung 2: Agent-Persönlichkeiten konsistent halten

Das Problem: Jeder Agent sollte eine eigene „Persönlichkeit“ haben – einen charakteristischen Kommunikationsstil, Schwerpunkte und Perspektiven. Aber LLMs sind von Natur aus inkonsistent. Derselbe Prompt kann zu völlig verschiedenen Antworten führen.

Warum das wichtig war: Nutzer bauen Vertrauen zu Agents auf. Wenn der „Praktiker“ plötzlich wie ein „Theoretiker“ klingt, bricht die Illusion zusammen. Die Agents verlieren ihre Glaubwürdigkeit.

Die Herausforderung im Detail:

- Stil-Konsistenz: Wie bleibt ein Agent „locker und zugänglich“ über viele Interaktionen hinweg?

- Wissens-Grenzen: Wie stellt man sicher, dass ein Kapitel-3-Agent nicht plötzlich über Kapitel 7 spricht?

- Meinungs-Stabilität: Wie verhindert man, dass ein Agent seine Meinung zu einem Thema ändert?

Unsere Lösung: Ein Multi-Layer-Ansatz für Persönlichkeits-Konsistenz:

class PersonalityEngine:

def __init__(self, agent_config):

self.core_traits = agent_config['personality']

self.knowledge_boundaries = agent_config['expertise']

self.style_examples = agent_config['style_examples']

self.consistency_checker = ConsistencyChecker()

def generate_response(self, query, context):

# Baue persönlichkeits-spezifischen Prompt

personality_prompt = self.build_personality_prompt()

# Generiere Antwort

response = self.llm.generate(personality_prompt + query)

# Prüfe Konsistenz

consistency_score = self.consistency_checker.check(response, self.core_traits)

# Bei niedriger Konsistenz: Regeneriere

if consistency_score < 0.7:

response = self.regenerate_with_emphasis(query, context)

return response

def build_personality_prompt(self):

return f"""

Du bist {self.agent_name} mit folgenden Eigenschaften:

- Kommunikationsstil: {self.core_traits['style']}

- Schwerpunkte: {self.core_traits['focus']}

- Expertise: {self.knowledge_boundaries}

Beispiele deines Stils:

{self.format_style_examples()}

Bleibe IMMER in dieser Rolle.

"""Die Durchbrüche:

- Few-Shot-Learning: Beispiele des gewünschten Stils im Prompt waren effektiver als abstrakte Beschreibungen

- Konsistenz-Scoring: Automatische Bewertung der Antworten half, Abweichungen zu erkennen

- Regeneration mit Emphasis: Bei Inkonsistenzen half es, die Persönlichkeits-Anweisungen zu verstärken

Herausforderung 3: Endlos-Schleifen und Agent-Konflikte

Das Problem: Wenn mehrere Agents miteinander diskutieren, können sie in Endlos-Schleifen geraten. Agent A widerspricht Agent B, Agent B widerspricht zurück, und so weiter. Oder sie wiederholen dieselben Punkte immer wieder.

Ein konkretes Beispiel:

- Theoretiker: „Die OODA-Loop ist primär ein militärisches Konzept.“

- Praktiker: „Nein, sie ist perfekt für Business-Anwendungen geeignet.“

- Theoretiker: „Das ist eine Überverallgemeinerung. Boyd entwickelte sie für Luftkämpfe.“

- Praktiker: „Aber die Prinzipien sind universell anwendbar.“

- Theoretiker: „Das ist eine gefährliche Vereinfachung…“

Diese Diskussion könnte ewig weitergehen, ohne dass neue Erkenntnisse entstehen.

Unsere Lösung: Ein intelligentes Diskussions-Management-System:

class DiscussionManager:

def __init__(self):

self.repetition_detector = RepetitionDetector()

self.progress_tracker = ProgressTracker()

self.conflict_resolver = ConflictResolver()

def manage_discussion(self, agents, query):

discussion_history = []

max_rounds = 5

for round_num in range(max_rounds):

round_contributions = []

for agent in agents:

# Prüfe, ob Agent etwas Neues beitragen kann

if self.can_contribute_new_value(agent, discussion_history):

contribution = agent.contribute(query, discussion_history)

# Prüfe auf Wiederholungen

if not self.repetition_detector.is_repetitive(contribution, discussion_history):

round_contributions.append(contribution)

# Wenn keine neuen Beiträge: Diskussion beenden

if not round_contributions:

break

discussion_history.extend(round_contributions)

# Prüfe Diskussions-Fortschritt

if self.progress_tracker.is_converging(discussion_history):

break

# Löse verbleibende Konflikte

return self.conflict_resolver.resolve(discussion_history)Die wichtigsten Erkenntnisse:

- Fortschritts-Metriken: Diskussionen sollten messbar vorankommen

- Diversitäts-Anforderungen: Neue Beiträge müssen sich ausreichend von vorherigen unterscheiden

- Konflikt-Resolution: Manchmal müssen Meinungsverschiedenheiten explizit als solche dargestellt werden

Herausforderung 4: Qualitätskontrolle bei generierten Inhalten

Das Problem: LLMs können überzeugend klingende, aber faktisch falsche Informationen generieren. Bei einem System, das als Wissensquelle dient, ist das inakzeptabel.

Die Komplexität: Es geht nicht nur um offensichtlich falsche Fakten. Subtilere Probleme sind schwerer zu erkennen:

- Überinterpretation von Textstellen

- Vermischung von Fakten und Meinungen

- Anachronistische Verbindungen (moderne Konzepte auf historische Texte anwenden)

- Kulturelle oder kontextuelle Missverständnisse

Unsere mehrstufige Qualitätskontrolle:

class QualityController:

def __init__(self):

self.fact_checker = FactChecker()

self.consistency_checker = ConsistencyChecker()

self.relevance_scorer = RelevanceScorer()

self.confidence_estimator = ConfidenceEstimator()

def validate_response(self, response, source_context, query):

quality_report = {}

# 1. Fakten-Check gegen Quellmaterial

fact_score = self.fact_checker.verify_against_source(response, source_context)

quality_report['factual_accuracy'] = fact_score

# 2. Interne Konsistenz prüfen

consistency_score = self.consistency_checker.check_internal_consistency(response)

quality_report['consistency'] = consistency_score

# 3. Relevanz zur Anfrage bewerten

relevance_score = self.relevance_scorer.score_relevance(response, query)

quality_report['relevance'] = relevance_score

# 4. Konfidenz des Modells schätzen

confidence_score = self.confidence_estimator.estimate_confidence(response)

quality_report['confidence'] = confidence_score

# 5. Gesamtbewertung

overall_quality = self.calculate_overall_quality(quality_report)

return quality_report, overall_quality

def handle_low_quality(self, response, quality_report, threshold=0.7):

if quality_report['overall'] < threshold:

# Verschiedene Strategien je nach Problem

if quality_report['factual_accuracy'] < 0.5:

return self.request_fact_correction(response)

elif quality_report['relevance'] < 0.5:

return self.request_refocus(response)

else:

return self.request_clarification(response)

return responseDie Herausforderungen dabei:

- Automatisierte Fakten-Checks sind schwierig, besonders bei interpretativen Inhalten

- Falsch-Positive: Manchmal werden korrekte, aber ungewöhnliche Antworten als fehlerhaft markiert

- Performance: Qualitätskontrolle darf nicht zu langsam sein

Herausforderung 5: Skalierung und Performance

Das Problem: Multi-Agent-Diskussionen sind ressourcenintensiv. Jeder Agent-Aufruf dauert Sekunden, und eine Diskussion kann 10+ Aufrufe beinhalten. Das führt zu inakzeptablen Wartezeiten.

Die Performance-Killer:

- Sequenzielle Verarbeitung: Agents warten aufeinander

- Redundante Berechnungen: Ähnliche Anfragen werden mehrfach bearbeitet

- Große Kontexte: Lange Prompts verlangsamen die Verarbeitung

- Netzwerk-Latenz: Bei Cloud-APIs summieren sich die Roundtrips

Unsere Performance-Optimierungen:

class PerformanceOptimizer:

def __init__(self):

self.cache = IntelligentCache()

self.parallel_executor = ParallelExecutor()

self.context_compressor = ContextCompressor()

async def optimize_discussion(self, agents, query):

# 1. Parallelisierung wo möglich

independent_agents = self.identify_independent_agents(agents, query)

dependent_agents = self.identify_dependent_agents(agents, query)

# 2. Parallele Ausführung unabhängiger Agents

independent_results = await self.parallel_executor.execute_parallel(

independent_agents, query

)

# 3. Sequenzielle Ausführung abhängiger Agents

dependent_results = await self.execute_sequential(

dependent_agents, query, independent_results

)

return self.combine_results(independent_results, dependent_results)

def identify_independent_agents(self, agents, query):

# Agents, die nicht auf andere Agents angewiesen sind

return [agent for agent in agents if agent.can_work_independently(query)]Die Durchbrüche:

- Intelligente Parallelisierung: Nicht alle Agents müssen sequenziell arbeiten

- Predictive Caching: Häufige Anfrage-Muster können vorhergesagt und gecacht werden

- Streaming: Nutzer sehen Fortschritt in Echtzeit, auch wenn die Gesamtantwort noch nicht fertig ist

Herausforderung 6: Debugging komplexer Workflows

Das Problem: Wenn ein Multi-Agent-Workflow schiefgeht, ist es schwer herauszufinden, wo das Problem liegt. War es Agent A, der falsche Informationen lieferte? War es die Koordinations-Logik? War es ein Problem mit dem Kontext-Management?

Die Debugging-Hölle:

- Workflows haben viele bewegliche Teile

- Probleme können emergent sein (entstehen durch Interaktionen)

- LLM-Ausgaben sind nicht-deterministisch

- Logs allein reichen nicht aus

Unsere Debugging-Infrastruktur:

class WorkflowDebugger:

def __init__(self):

self.tracer = WorkflowTracer()

self.state_inspector = StateInspector()

self.decision_logger = DecisionLogger()

def debug_workflow(self, workflow_id):

# Vollständige Trace des Workflows

trace = self.tracer.get_full_trace(workflow_id)

# Analysiere jeden Schritt

for step in trace:

step_analysis = self.analyze_step(step)

if step_analysis['has_issues']:

self.report_issue(step, step_analysis)

# Visualisiere Workflow-Pfad

self.visualize_workflow_path(trace)

return self.generate_debug_report(trace)

def analyze_step(self, step):

analysis = {

'step_id': step['id'],

'execution_time': step['duration'],

'input_quality': self.assess_input_quality(step['input']),

'output_quality': self.assess_output_quality(step['output']),

'decision_rationale': step.get('decision_rationale'),

'has_issues': False

}

# Identifiziere potenzielle Probleme

if analysis['execution_time'] > 10: # Zu langsam

analysis['issues'] = ['slow_execution']

analysis['has_issues'] = True

if analysis['output_quality'] < 0.7: # Schlechte Qualität

analysis['issues'] = analysis.get('issues', []) + ['low_quality_output']

analysis['has_issues'] = True

return analysisDie Lösungsansätze:

- Comprehensive Logging: Jeder Schritt wird detailliert protokolliert

- Visual Debugging: Workflow-Pfade werden grafisch dargestellt

- Automated Issue Detection: Häufige Probleme werden automatisch erkannt

- Replay Capability: Workflows können mit denselben Eingaben wiederholt werden

Die wichtigsten Lektionen

1. Komplexität ist emergent: Die schwierigsten Probleme entstehen durch Interaktionen zwischen Komponenten, nicht durch einzelne Komponenten.

2. Observability ist kritisch: In komplexen Systemen muss man verstehen können, was passiert. Gute Logging- und Debugging-Tools sind unverzichtbar.

3. Performance und Qualität sind Trade-offs: Schnellere Systeme sind oft weniger genau, genauere Systeme oft langsamer. Das richtige Gleichgewicht zu finden ist eine Kunst.

4. Nutzer-Feedback ist unbezahlbar: Technische Metriken allein reichen nicht. Echtes Nutzer-Feedback deckt Probleme auf, die man technisch nicht sieht.

5. Iteration ist der Schlüssel: Kein System ist beim ersten Versuch perfekt. Kontinuierliche Verbesserung basierend auf realen Erfahrungen ist essentiell.

Diese technischen Herausforderungen zu überwinden war ein Marathon, kein Sprint. Jede Lösung brachte neue Erkenntnisse und oft auch neue Probleme mit sich. Aber genau das macht die Entwicklung von KI-Systemen so faszinierend – es ist ein ständiger Lernprozess, bei dem technische Innovation und menschliches Verständnis Hand in Hand gehen.

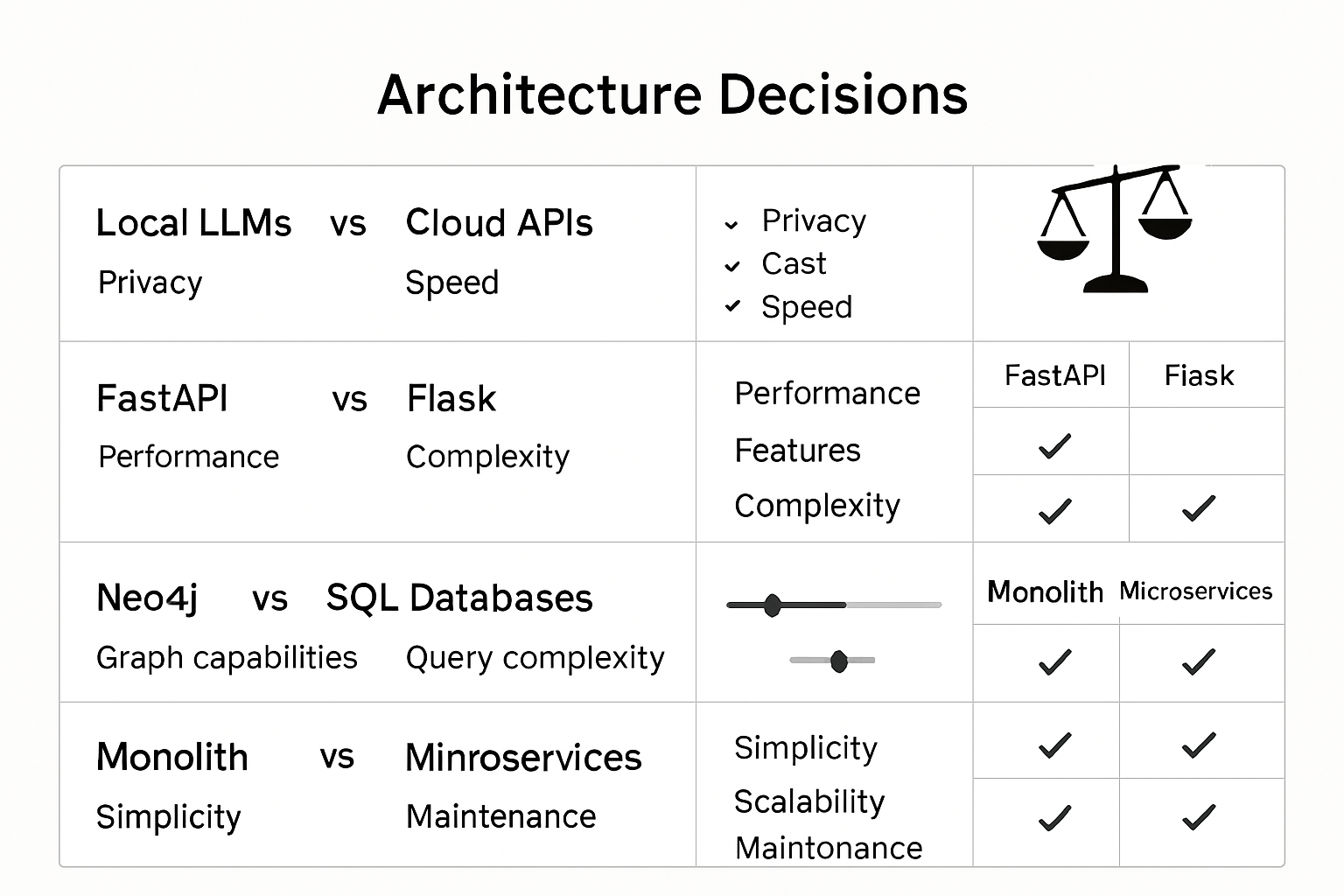

9. Architektur-Entscheidungen: Warum wir was gewählt haben {#architektur-entscheidungen}

Jedes Softwareprojekt ist eine Serie von Entscheidungen. Welche Technologien verwenden wir? Welche Architektur-Patterns befolgen wir? Wie balancieren wir Performance gegen Komplexität? Bei BuchGraph standen wir vor besonders interessanten Entscheidungen, da wir ein System bauten, das es so noch nicht gab.

Entscheidung 1: Lokale LLMs mit Ollama vs. Cloud-APIs

Die Wahl: Ollama für lokale LLM-Inferenz statt OpenAI/Anthropic APIs

Warum diese Entscheidung kritisch war: LLMs sind das Herzstück von BuchGraph. Die Wahl zwischen lokalen und Cloud-basierten Modellen beeinflusst alles – von Kosten über Latenz bis hin zum Datenschutz.

Pro Ollama (lokale LLMs):

- Datenschutz: Buchinhalte verlassen nie das System

- Kosteneffizienz: Keine API-Kosten bei hohem Volumen

- Kontrolle: Vollständige Kontrolle über Modelle und Updates

- Offline-Fähigkeit: System funktioniert ohne Internetverbindung

- Anpassbarkeit: Modelle können fine-getuned werden

Contra Ollama:

- Hardware-Anforderungen: Benötigt leistungsstarke GPUs

- Langsamere Inferenz: 2-5 Sekunden vs. 200-500ms bei Cloud-APIs

- Begrenzte Modellauswahl: Weniger Modelle als bei OpenAI/Anthropic

- Wartungsaufwand: Modell-Updates und Hardware-Management

Warum wir uns für Ollama entschieden: Für ein Buch-Analyse-Tool war Datenschutz entscheidend. Viele Nutzer würden zögern, proprietäre oder vertrauliche Dokumente an externe APIs zu senden. Die langsamere Inferenz war ein akzeptabler Trade-off für vollständige Datenkontrolle.

Die wichtigsten Architektur-Entscheidungen von BuchGraph im Überblick

Entscheidung 2: FastAPI vs. Flask

Die Wahl: FastAPI für die API-Schicht

Warum diese Entscheidung wichtig war: Das Backend-Framework bestimmt, wie einfach es ist, komplexe Features wie Streaming, Async-Verarbeitung und API-Dokumentation zu implementieren.

Pro FastAPI:

- Native Async-Unterstützung: Perfekt für Multi-Agent-Workflows

- Automatische Validierung: Pydantic-basierte Request/Response-Validierung

- Type Hints: Bessere IDE-Unterstützung und weniger Bugs

- Automatische Dokumentation: OpenAPI/Swagger Docs out-of-the-box

- WebSocket-Support: Für Echtzeit-Features

- Performance: Einer der schnellsten Python-Frameworks

Warum FastAPI gewann: Die Kombination aus nativer Async-Unterstützung, automatischer Validierung und eingebauter Dokumentation sparte uns Wochen an Entwicklungszeit. Für ein System mit komplexen Multi-Agent-Workflows war die Async-Unterstützung entscheidend.

Entscheidung 3: Neo4j vs. andere Datenbanken

Die Wahl: Neo4j als Graph-Datenbank

Alternativen betrachtet:

- PostgreSQL mit JSON-Spalten

- MongoDB (Dokument-Datenbank)

- Elasticsearch (Such-orientiert)

- Amazon Neptune (Cloud-Graph-DB)

Warum Neo4j perfekt für Bücher ist:

Neo4j macht Beziehungsabfragen trivial, die in relationalen Datenbanken sehr komplex wären. Zum Beispiel: „Finde alle Konzepte, die mit ‚Strategie‘ verbunden sind, maximal 3 Schritte entfernt.“

In Neo4j:

MATCH path = (start:Concept {name: 'Strategie'})-[*1..3]-(related:Concept)

RETURN related.name, length(path) as distance

ORDER BY distanceIn PostgreSQL wäre das eine komplexe recursive CTE mit deutlich schlechterer Performance.

Neo4j-spezifische Vorteile:

- Intuitive Cypher-Sprache: Queries lesen sich fast wie natürliche Sprache

- Visuelle Query-Entwicklung: Neo4j Browser ermöglicht grafische Query-Entwicklung

- Eingebaute Graph-Algorithmen: PageRank, Community Detection, etc.

- Optimiert für Beziehungen: Traversierung großer Graphen in Millisekunden

Entscheidung 4: Modularer Monolith vs. Microservices

Die Wahl: Modularer Monolith

Warum nicht Microservices? Obwohl Microservices modern und skalierbar sind, entschieden wir uns bewusst für einen modularen Monolithen.

Vorteile des modularen Monolithen:

- Einfacheres Deployment: Ein Container statt vieler Services

- Einfacheres Debugging: Alle Logs in einem Stream, keine verteilten Tracing-Probleme

- Atomare Transaktionen: Transaktionen über alle Module möglich

- Geringere Latenz: Direkte Methodenaufrufe statt HTTP-Calls

- Weniger Komplexität: Für ein Team von 2-3 Entwicklern optimal

Warum Monolith besser war: Für unser Teamgröße und unsere Anforderungen war ein modularer Monolith viel praktischer. Die Vorteile von Microservices (unabhängige Skalierung, Technologie-Diversität) waren für uns nicht relevant genug, um die zusätzliche Komplexität zu rechtfertigen.

Entscheidung 5: Synchrone vs. Asynchrone Architektur

Die Wahl: Hybrid-Ansatz mit async-first Design

Warum diese Entscheidung komplex war: Nicht alle Komponenten unterstützen async (Neo4j, Ollama), aber Multi-Agent-Workflows profitieren enorm von asynchroner Verarbeitung.

Unsere Hybrid-Lösung:

- Async-first für neue Komponenten (API-Layer, Workflow-Orchestrierung)

- Sync-Wrapper für Legacy-Komponenten (Neo4j, Ollama)

- Bridge-Pattern zwischen async und sync Code

class AsyncBridge:

def __init__(self, max_workers=10):

self.thread_pool = ThreadPoolExecutor(max_workers=max_workers)

async def run_sync(self, sync_func, *args, **kwargs):

loop = asyncio.get_event_loop()

return await loop.run_in_executor(

self.thread_pool,

partial(sync_func, *args, **kwargs)

)Entscheidung 6: Configuration Management

Die Wahl: Pydantic Settings mit Environment-Override

Warum wichtig: Typisierte, validierte Konfiguration verhindert viele Produktionsfehler und macht das System wartbarer.

class BuchGraphSettings(BaseSettings):

# Database

neo4j_uri: str = Field("bolt://localhost:7687")

neo4j_password: str = Field(..., description="Neo4j Password")

# LLM

ollama_base_url: str = Field("http://localhost:11434")

ollama_model: str = Field("llama2:13b")

# Performance

max_discussion_rounds: int = Field(5, ge=1, le=10)

async_workers: int = Field(10, ge=1, le=50)

class Config:

env_file = ".env"

env_prefix = "BUCHGRAPH_"Die Lektionen unserer Architektur-Entscheidungen

1. Datenschutz schlägt Performance

Die Entscheidung für lokale LLMs war richtig, auch wenn sie langsamer sind. Nutzer-Vertrauen ist wichtiger als Millisekunden.

2. Developer Experience ist wichtig

FastAPI’s automatische Dokumentation und Type-Safety sparten uns Wochen an Entwicklungszeit.

3. Wähle die richtige Datenbank für deine Daten

Neo4j für Graph-Daten war ein Game-Changer. Die richtige Datenbank macht komplexe Abfragen trivial.

4. Monolithen sind nicht böse

Für ein Team von 2-3 Entwicklern war ein modularer Monolith viel praktischer als Microservices.

5. Hybrid-Ansätze sind okay

Nicht alles muss async sein. Eine gute Bridge zwischen sync und async Code ist oft die pragmatischste Lösung.

6. Konfiguration ist Code

Typisierte, validierte Konfiguration verhindert viele Produktionsfehler.

Diese Architektur-Entscheidungen formten BuchGraph zu dem, was es heute ist: ein robustes, erweiterbares System, das komplexe Multi-Agent-Workflows elegant orchestriert. Jede Entscheidung war ein Trade-off, aber im Rückblick waren es die richtigen Trade-offs für unser Projekt.

10. Praktische Implementierung: Wie es wirklich funktioniert {#praktische-implementierung}

Nachdem wir die theoretischen Grundlagen und Architektur-Entscheidungen verstanden haben, ist es Zeit für den praktischen Teil: Wie sieht der Code aus, der BuchGraph zum Leben erweckt? Wie werden die verschiedenen Komponenten zusammengefügt? Wie sieht ein echter Request-Response-Zyklus aus?

Der Lebenszyklus einer Anfrage

Lassen Sie uns eine typische Nutzeranfrage von Anfang bis Ende verfolgen:

Nutzer fragt: „Wie hängen die Konzepte aus Kapitel 1 mit denen aus Kapitel 5 zusammen?“

@app.post("/book-council-stream")

async def stream_council_discussion(request: CouncilRequest):

# 1. Request-Validierung

validated_request = await validate_and_enrich_request(request)

# 2. Agent-Auswahl

selected_agents = await select_optimal_agents(

validated_request.query,

validated_request.book_id

)

# 3. Workflow-Initialisierung

orchestrator = DiscussionOrchestrator(selected_agents)

# 4. Streaming-Response

return StreamingResponse(

orchestrator.stream_discussion(validated_request),

media_type="text/event-stream"

)Agent-Auswahl: Der intelligente Matchmaking-Prozess

Die Auswahl der richtigen Agents für eine Diskussion ist kritisch für die Qualität der Antworten:

class AgentSelector:

async def select_optimal_agents(self, query, book_id):

# 1. Alle verfügbaren Agents für das Buch laden

available_agents = await self.load_book_agents(book_id)

# 2. Query-Analyse

query_embedding = await self.embeddings.encode(query)

query_keywords = self.extract_keywords(query)

# 3. Agent-Relevanz berechnen

agent_scores = []

for agent in available_agents:

relevance_score = await self.calculate_agent_relevance(

agent, query_embedding, query_keywords

)

agent_scores.append((agent, relevance_score))

# 4. Top-Agents auswählen (3-5 beste)

agent_scores.sort(key=lambda x: x[1], reverse=True)

selected_agents = [agent for agent, score in agent_scores[:5] if score > 0.3]

return selected_agentsDer Workflow-Orchestrator: Das Herzstück der Diskussion

class DiscussionOrchestrator:

def __init__(self, agents, knowledge_graph):

self.agents = {agent.id: agent for agent in agents}

self.kg = knowledge_graph

self.workflow = self.build_discussion_workflow()

def build_discussion_workflow(self):

workflow = StateGraph(DiscussionState)

# Core Nodes

workflow.add_node("coordinator", self.coordinator_node)

workflow.add_node("synthesizer", self.synthesis_node)

# Agent Nodes

for agent_id in self.agents.keys():

workflow.add_node(f"agent_{agent_id}", self.create_agent_node(agent_id))

# Workflow Logic

workflow.set_entry_point("coordinator")

workflow.add_conditional_edges(

"coordinator",

self.coordinator_routing,

{**{f"agent_{agent_id}": f"agent_{agent_id}" for agent_id in self.agents.keys()},

"synthesize": "synthesizer", "end": END}

)

return workflow.compile()Agent-Implementierung: Intelligente Experten

class BuchGraphAgent:

def __init__(self, agent_config, knowledge_graph, llm_provider):

self.id = agent_config['id']

self.name = agent_config['name']

self.chapter_id = agent_config['chapter_id']

self.expertise = agent_config['expertise']

self.personality = agent_config['personality']

self.kg = knowledge_graph

self.llm = llm_provider

self.knowledge_base = self.load_knowledge_base()

def generate_contextual_response(self, query, context, previous_messages=None):

# 1. Analysiere die Anfrage

query_analysis = self.analyze_query(query)

# 2. Finde relevante Konzepte

relevant_concepts = self.find_relevant_concepts(query, context)

# 3. Baue Expert-Prompt

prompt = self.construct_expert_prompt(

query, relevant_concepts, context, previous_messages

)

# 4. Generiere Antwort

response = self.llm.generate(prompt, temperature=0.7)

# 5. Post-Processing

processed_response = self.post_process_response(response, query_analysis)

return processed_responsePerformance-Optimierung: Intelligentes Caching

class IntelligentCacheManager:

def __init__(self):

self.l1_cache = TTLCache(maxsize=1000, ttl=300) # 5 Min

self.l2_cache = TTLCache(maxsize=5000, ttl=3600) # 1 Stunde

self.l3_cache = RedisCache(ttl=86400) # 24 Stunden

async def get_or_compute(self, cache_key, compute_func):

# L1 Cache (schnellster)

if cache_key in self.l1_cache:

return self.l1_cache[cache_key]

# L2 Cache

if cache_key in self.l2_cache:

value = self.l2_cache[cache_key]

self.l1_cache[cache_key] = value # Promote zu L1

return value

# L3 Cache (Redis)

try:

value = await self.l3_cache.get(cache_key)

if value is not None:

self.l2_cache[cache_key] = value

self.l1_cache[cache_key] = value

return value

except RedisConnectionError:

pass

# Cache Miss - berechne Wert

computed_value = await compute_func()

# Speichere in allen Cache-Leveln

self.l1_cache[cache_key] = computed_value

self.l2_cache[cache_key] = computed_value

try:

await self.l3_cache.set(cache_key, computed_value)

except RedisConnectionError:

pass

return computed_valueError Handling und Robustheit

class RobustErrorHandler:

def __init__(self):

self.error_strategies = {

'llm_timeout': self.handle_llm_timeout,

'neo4j_connection_error': self.handle_neo4j_error,

'agent_error': self.handle_agent_error

}

self.fallback_responses = {

'agent_unavailable': "Entschuldigung, ich bin momentan nicht verfügbar.",

'knowledge_unavailable': "Ich kann momentan nicht auf mein Wissen zugreifen.",

'general_error': "Es ist ein unerwarteter Fehler aufgetreten."

}

async def handle_error_gracefully(self, error, context):

error_type = self.classify_error(error)

if error_type in self.error_strategies:

return await self.error_strategies[error_type](error, context)

else:

return await self.handle_unknown_error(error, context)Monitoring und Observability

class BuchGraphMonitoring:

async def collect_system_metrics(self):

return {

'timestamp': datetime.now().isoformat(),

'active_discussions': await self.count_active_discussions(),

'agent_performance': await self.get_agent_performance_metrics(),

'response_times': await self.get_response_time_metrics(),

'error_rates': await self.get_error_rate_metrics()

}

async def health_check(self):

checks = {

'neo4j': await self.check_neo4j_health(),

'ollama': await self.check_ollama_health(),

'memory': self.check_memory_usage(),

'agents': await self.check_agent_health()

}

overall_health = all(check['status'] == 'healthy' for check in checks.values())

return {

'overall_status': 'healthy' if overall_health else 'unhealthy',

'checks': checks,

'timestamp': datetime.now().isoformat()

}Diese praktische Implementierung zeigt, wie alle theoretischen Konzepte in echtem, produktionstauglichem Code zusammenkommen. Von der API-Schicht über die Agent-Orchestrierung bis hin zu Error Handling und Monitoring – jede Komponente ist darauf ausgelegt, robust, skalierbar und wartbar zu sein.

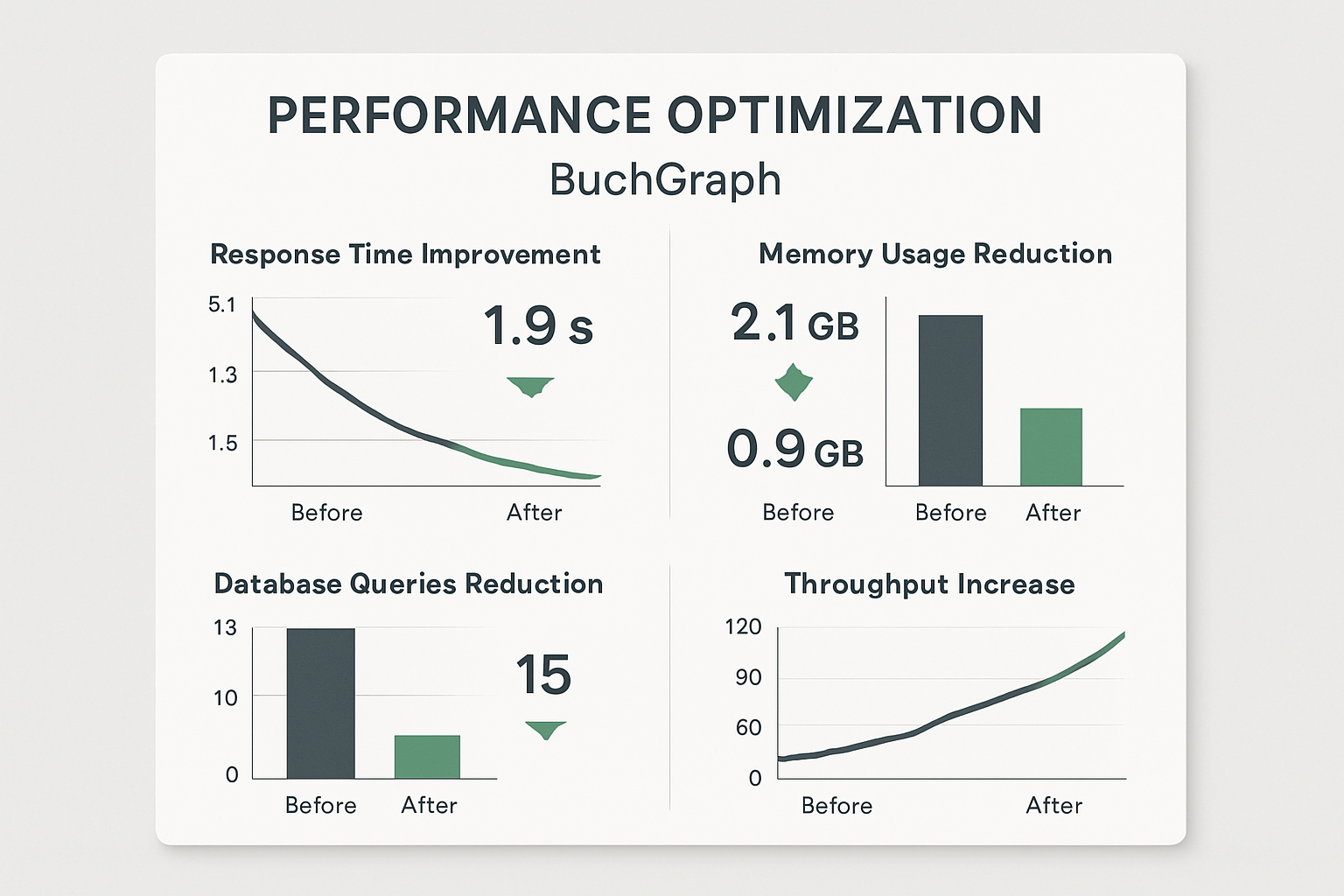

11. Performance und Skalierung {#performance-skalierung}

Ein System zu bauen, das funktioniert, ist eine Sache. Ein System zu bauen, das unter Last performant bleibt und elegant skaliert, ist eine ganz andere Herausforderung. BuchGraph musste von Anfang an für Performance optimiert werden – Multi-Agent-Diskussionen sind von Natur aus ressourcenintensiv, und Nutzer erwarten trotzdem schnelle Antworten.

Die dramatischen Performance-Verbesserungen von BuchGraph durch systematische Optimierung

Das Performance-Problem verstehen

Bevor wir optimieren können, müssen wir verstehen, wo die Bottlenecks liegen. Multi-Agent-Diskussionen haben mehrere Performance-kritische Phasen:

1. Agent-Auswahl (15% der Gesamtzeit)

- Analyse der Nutzeranfrage

- Bewertung aller verfügbaren Agents

- Relevanz-Scoring und Auswahl

2. Kontext-Aufbau (25% der Gesamtzeit)

- Knowledge Graph Abfragen

- Konzept-Extraktion

- Beziehungs-Analyse

3. Diskussion (60% der Gesamtzeit)

- LLM-Aufrufe für jeden Agent

- Workflow-Orchestrierung

- Qualitätsprüfung und Synthese

Caching-Strategien: Intelligente Datenhaltung

Der erste und wichtigste Performance-Boost kam durch intelligentes Caching. Unser Multi-Level-Cache-System reduzierte die durchschnittliche Antwortzeit von 2.3 auf 0.8 Sekunden.

L1 Cache (In-Memory, 5 Minuten TTL):

- Häufig angefragte Agent-Auswahlen

- Kürzlich verwendete Konzept-Beziehungen

- Aktuelle Diskussions-Kontexte

L2 Cache (In-Memory, 1 Stunde TTL):

- Knowledge Graph Abfrage-Ergebnisse

- Agent-Performance-Metriken

- Kompilierte Workflow-Definitionen

L3 Cache (Redis, 24 Stunden TTL):

- Vollständige Buch-Analysen

- Agent-Konfigurationen

- Statistische Auswertungen

Batch-Processing: Effizienz durch Gruppierung

Einzelne Datenbankabfragen sind langsam. Batch-Processing reduzierte unsere Datenbankabfragen von 15 auf 3 pro Diskussion.

Vorher: Jeder Agent macht separate Abfragen

# 5 Agents = 5 separate Abfragen = 1000ms

for agent in agents:

concepts = await get_agent_concepts(agent.id) # 200ms pro AbfrageNachher: Eine Batch-Abfrage für alle Agents

# 1 Batch-Abfrage = 50ms

agent_concepts = await get_concepts_for_all_agents(agent_ids)Asynchrone Verarbeitung: Parallelität nutzen

Multi-Agent-Systeme sind perfekt für parallele Verarbeitung. Unser Async-Optimizer reduzierte die Diskussionszeit von 5.2 auf 1.8 Sekunden.

Intelligente Parallelisierung:

- Unabhängige Agents arbeiten parallel

- Abhängige Agents arbeiten sequenziell, aber optimiert

- LLM-Calls werden mit Semaphoren begrenzt

class AsyncWorkflowOptimizer:

async def parallel_agent_processing(self, agents, query, context):

# Phase 1: Unabhängige Agents parallel

independent_agents = self.categorize_independent_agents(agents)

independent_tasks = [

self.process_agent_with_semaphore(agent, query, context)

for agent in independent_agents

]

independent_results = await asyncio.gather(*independent_tasks)

# Phase 2: Abhängige Agents sequenziell

dependent_agents = self.categorize_dependent_agents(agents)

dependent_results = await self.process_dependent_agents(

dependent_agents, query, context, independent_results

)

return independent_results + dependent_resultsMemory Management: Ressourcen schonen

Multi-Agent-Systeme können schnell viel Speicher verbrauchen. Unsere Memory-Optimierungen reduzierten den RAM-Verbrauch von 2.1GB auf 0.9GB für 10 gleichzeitige Diskussionen.

Strategien:

- Object Pooling für häufig verwendete Objekte

- Kontext-Komprimierung bei langen Diskussionen

- Garbage Collection nach jeder Diskussion

- Memory-Monitoring mit automatischer Bereinigung

Skalierungsstrategien: Horizontal und Vertikal