Wie kann ich tausende Euro im Jahr mit lokalen KI-Lösungen sparen?

Die Kosten explodierenden wenn man viel mit KI-Lösungen arbeitet, meine letzte monatliche Rechnung war über 250 Euro bei OpenAI, Grund genug eine lokale KI-Lösungen aufzubauen!

Was sind die Bausteine einer lokalen KI Lösung?

- PrivateGPT als KI-Datenhaltung und Chatsystem

- Ollama mit der Möglichkeit mit lokalen KI-Systemen zu chatten oder Workflows zu bauen. Hier kann man einfach verschiedene KI-Syteme testen

- Rivet AI um Workflows zu genieren

- Keyboard Maestro um lokale Dateien einfach in PrivateGPT zu uploaden

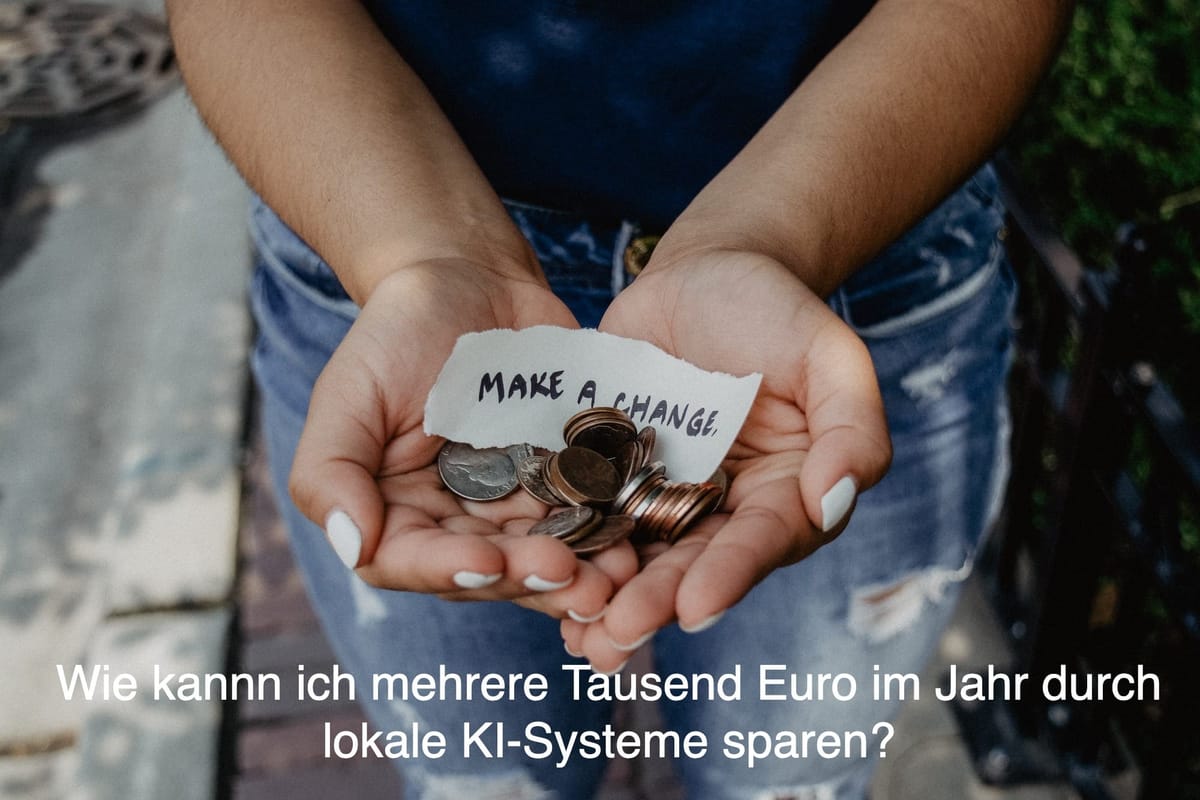

Wie rede ich mit meinen lokalen Büchern?

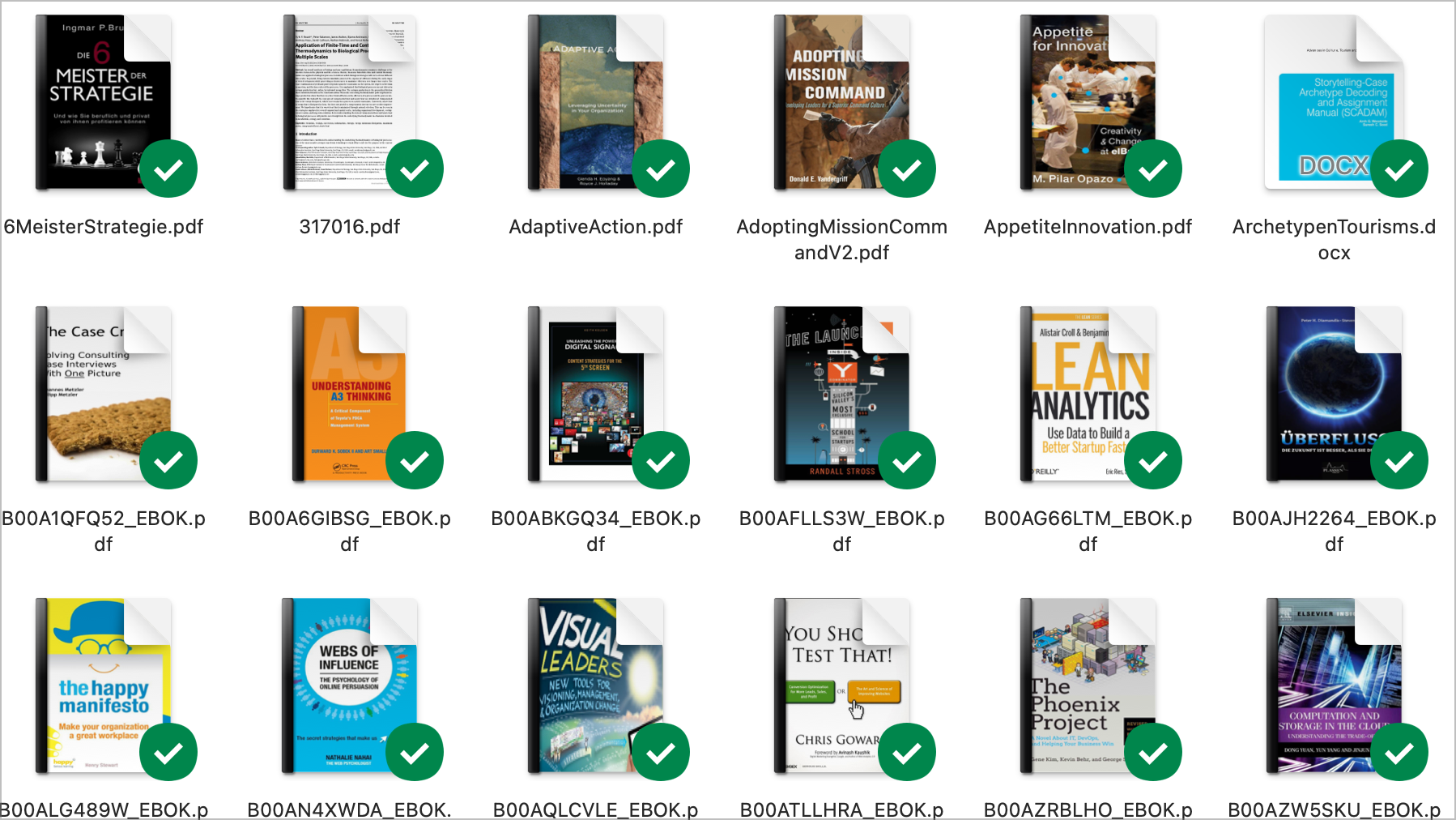

Viele Ratgeber und Experten möchte ich systematisch nach Wissen fragen und Rat einholen zu praktischen Fragestellungen.

Hier in dem Beitrag habe ich gezeigt, wie ich das in der Cloud umsetze:

Wie kann ich systematisch meine Quellen (pdf, ppt) abfragen?

Dazu habe ich folgenden Workflow entwickelt:

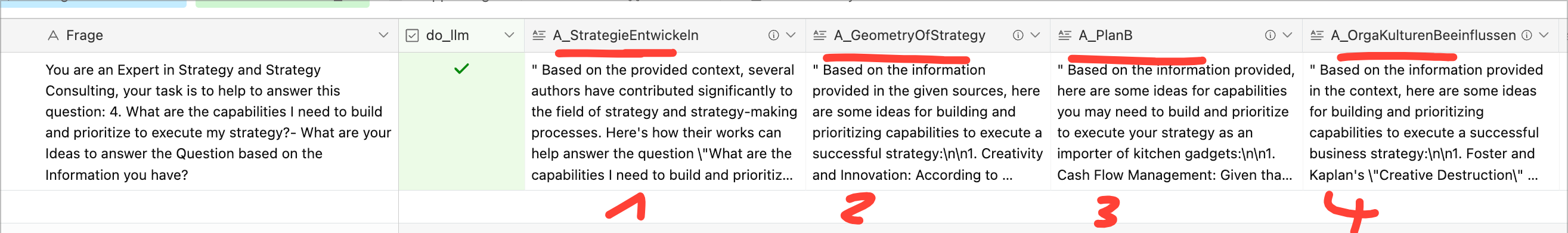

- Aufbau eine Airtable Datenbank mit den Fragen und den Büchern die ich abfragen möchte

Hier ist ein Ausschnitt von 100 Fragen und vier Büchern, in den meisten Fällen frage ich 10-15 Bücher ab.

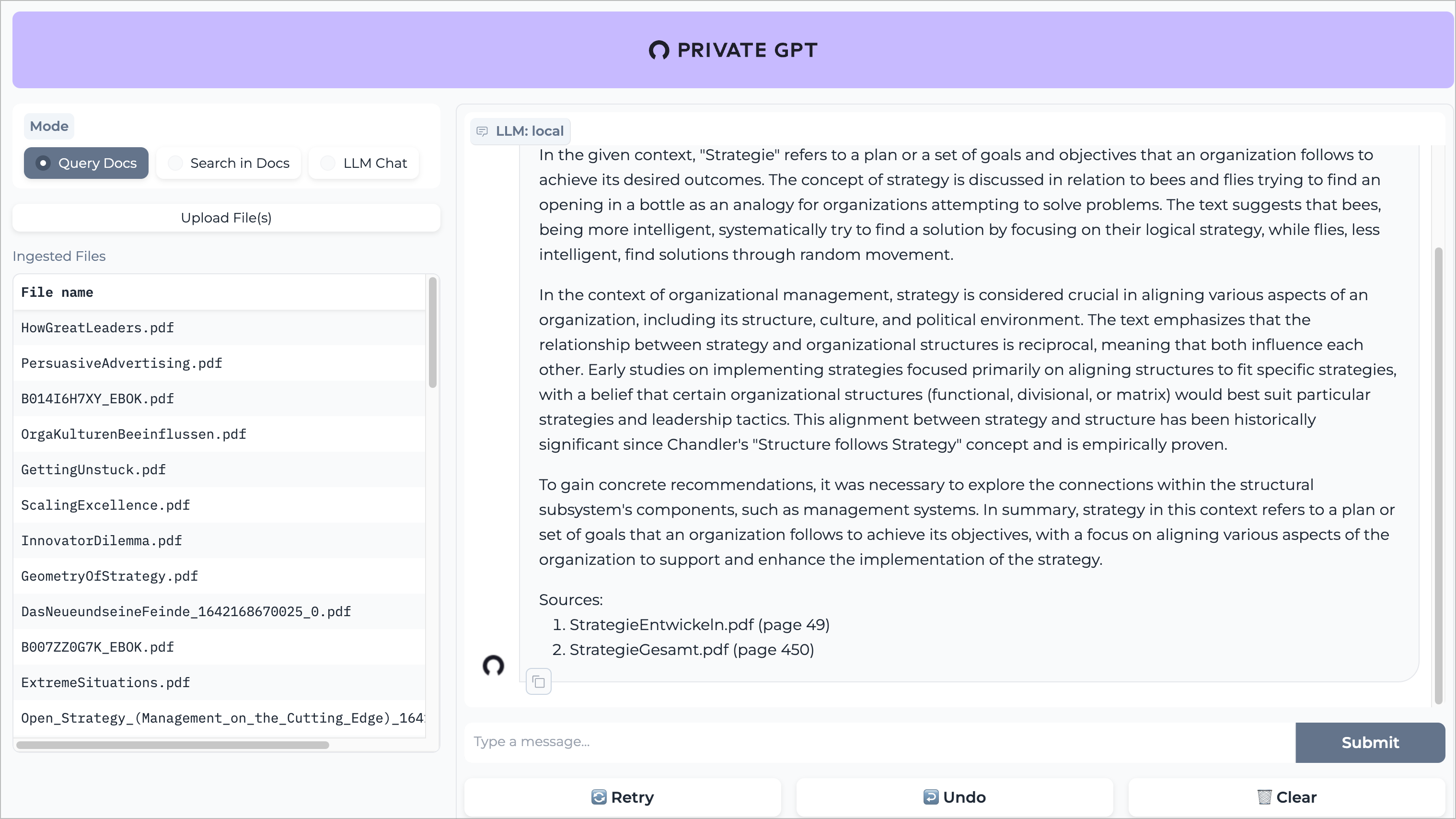

- Private GPT aufbauen

Private GPT lässt sich einfach über diese Anleitung installieren https://docs.privategpt.dev/installation

Die Installation dauert ungefähr 10-20 Minuten. Dann hat man eine lokale KI installiert in der man die Dokumente einfach uploaden kann.

Der Nachteil des einfachen Uploads ist, das wir aus den ganzen Büchern eine KI-Datenbank machen und eine Abfrage läuft dann über alle Bücher. Das ist gut für ein zentrales Wissensmanagement, in den meisten Fällen möchte ich aber gezielt ein Buch abfragen.

Wie geht das?

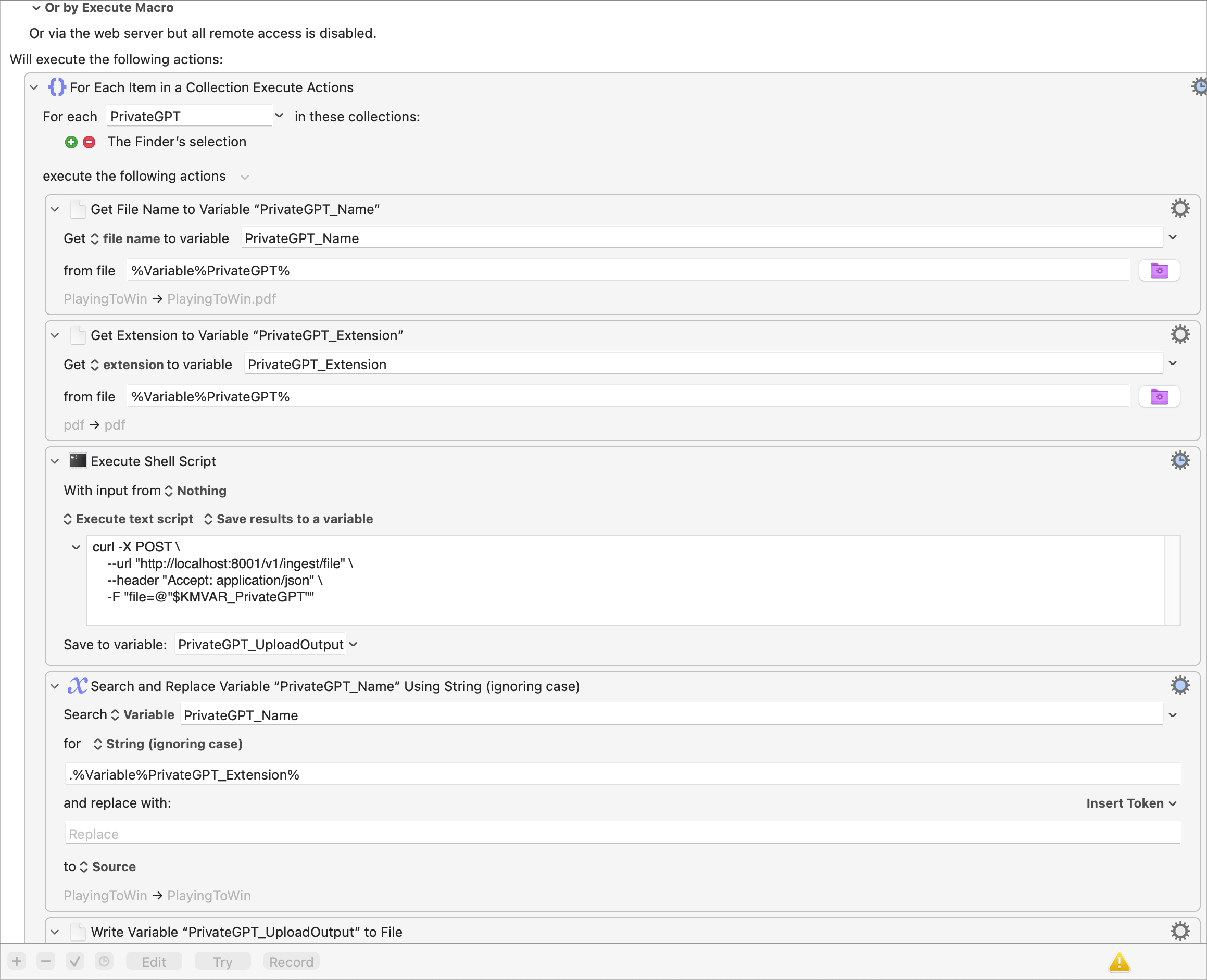

Upload (ingest) der Bücher in KeyBoard Maestro.

Ich klicke einfach über den Finder mehrere PDFs oder andere Dateien an und über einen Shortcut wird das PDF, pptx etc.. über die API an PrivateGPT übertragen.

Jedes Seite die in die Vector Datenbank hochgeladen wird, bekommt eine ID, die die API zurückgibt. Wenn ein Buch 300 Seiten hat,gibt es dreihundert IDs, die brauche ich dann wenn ich genau diese Buch abfragen möchte.

Das Keyboard Maestro Script macht das genau und speichert die IDs des Buches in einer Datei.

Den Pfad übertrage ich nach Airtable, damit jedes PDF weiß wo die Daten sind zur Abfrage.

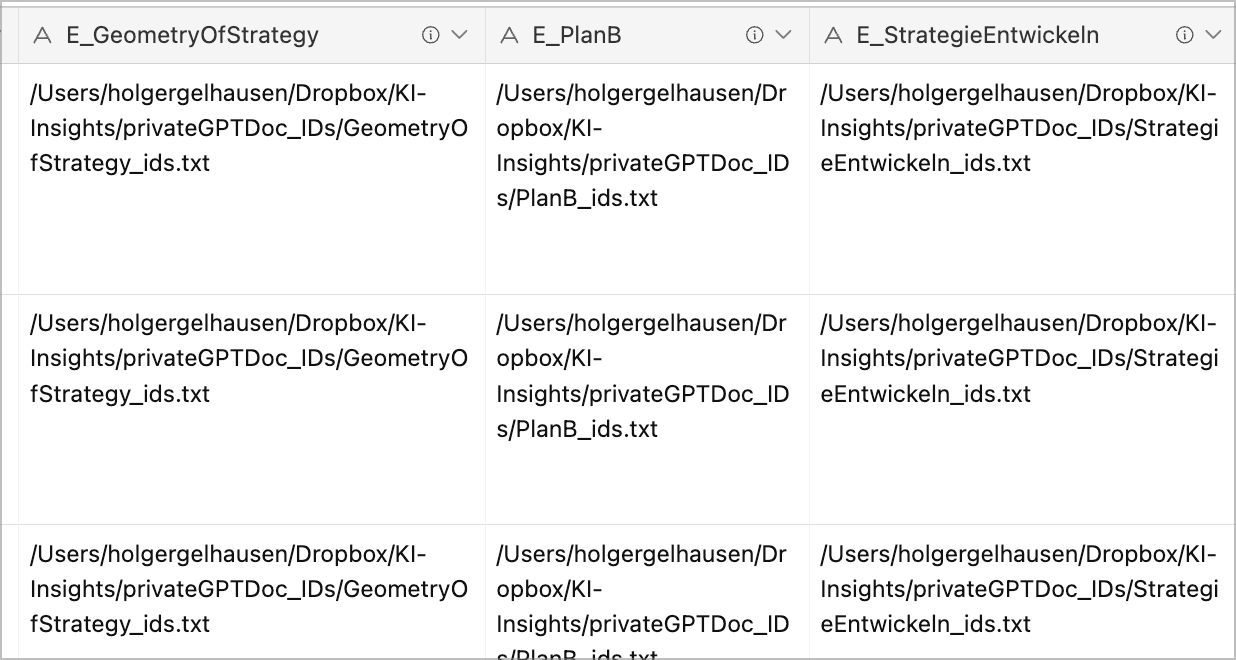

Hier ist ein Inhalt einer Datei, das muss ich selbst nicht wissen, ich gebe dem Abfrage Programm den Pfad mit und das war es dann, den Rest erledigt dann Rivet.

Übertrag des Pfades an zur Airtable Datenbank

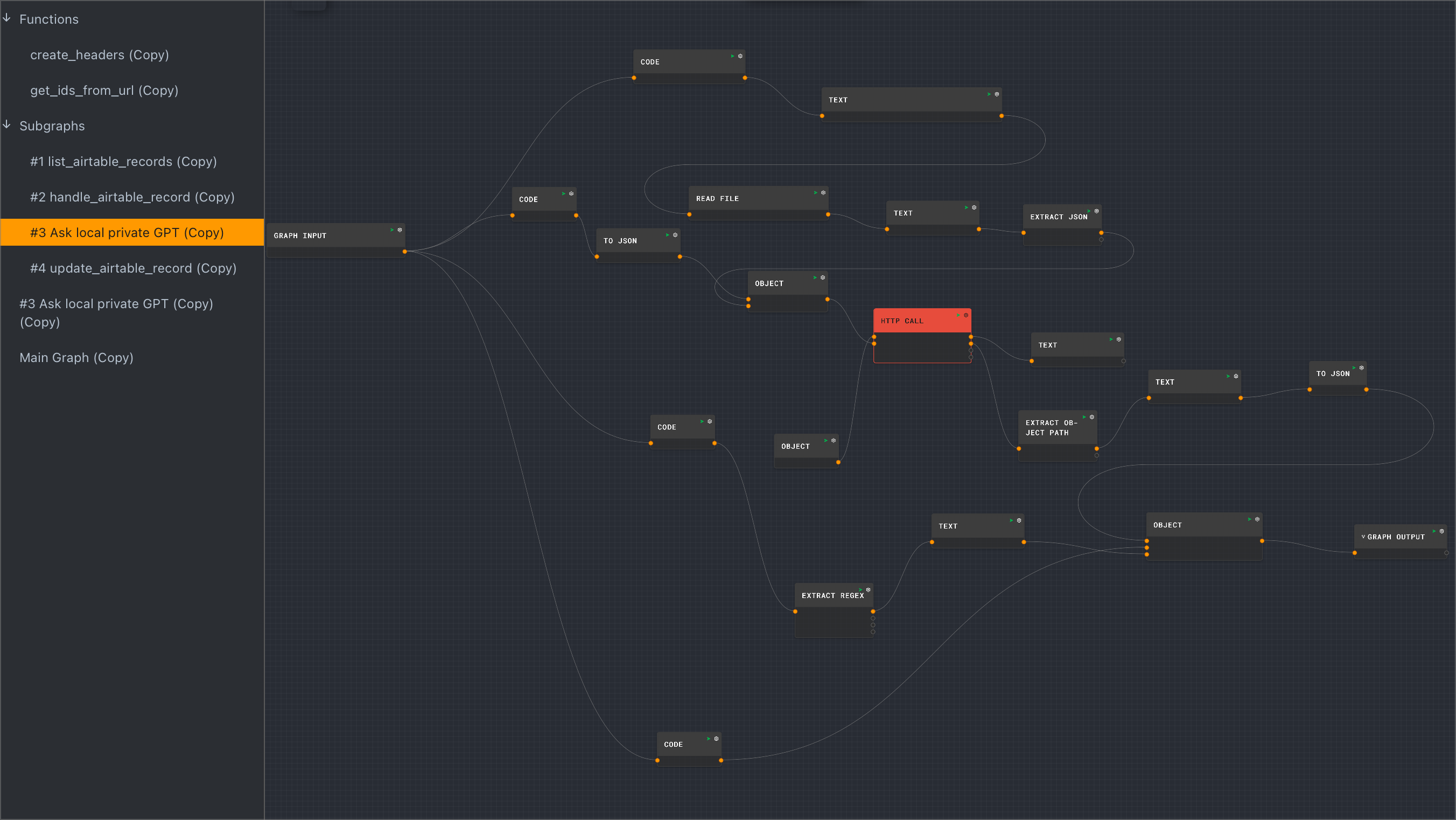

Eine Rivet.AI Workflow aufbauen

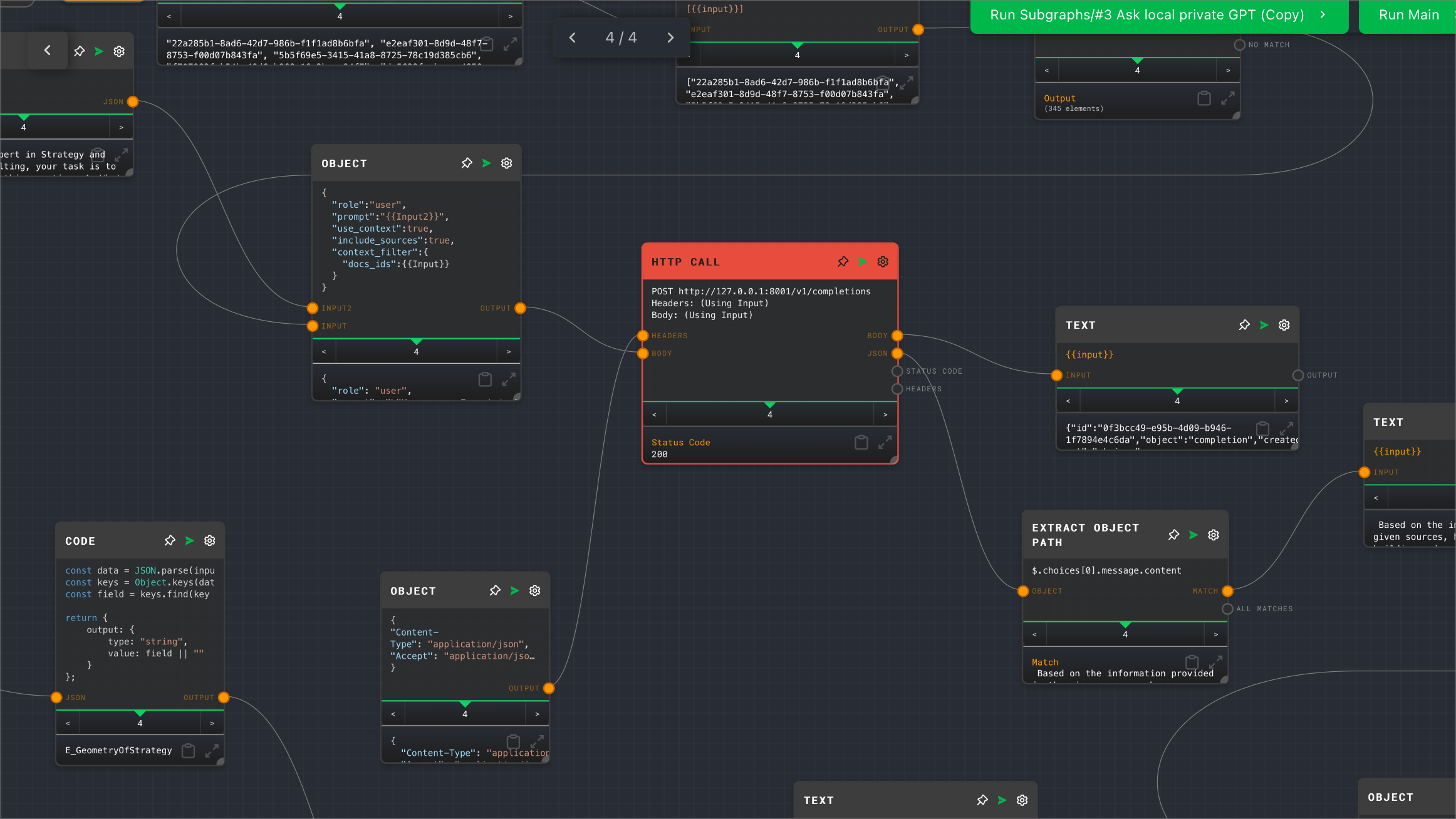

Rivet AI bietet die Möglichkeit über http Calls die lokale PrivateGPT Datenbank abzufragen.

Die Grundstruktur des Airtable Workflows ist von

und hier auf dem Youtube Kanal super erklärt! Danke für die tollen Videos und Hilfe!!

Der Workflow sieht vereinfacht so aus:

- Hole alle Records (die Fragen) in Airtable

- Analysiere die Records und suche die Felder E_ (dort ist der Pfad zur lokalen ID Datei) und splitte jedes Buch und Frage auf.

- Frage die lokale PrivateGPT KI was der Author (das Buch) zu der Frage zu sagen hat

- Lade die Antwort nach Airtable zurück.

Das Herzstück ist der HTTP Call in der Mitte der Skizze

Weiter oben im Bild sieht man die IDs die dann dem Call mitgeben werden.

Eine Abfrage der lokalen KI dauert ungefähr 8-10 Sekunden. Den Workflow schauen wir uns detaillierter in einer Mittwoch Session an. Vielleicht habe ich auch Zeit ein Video dazu zu machen.

Was spare ich an Kosten ein?

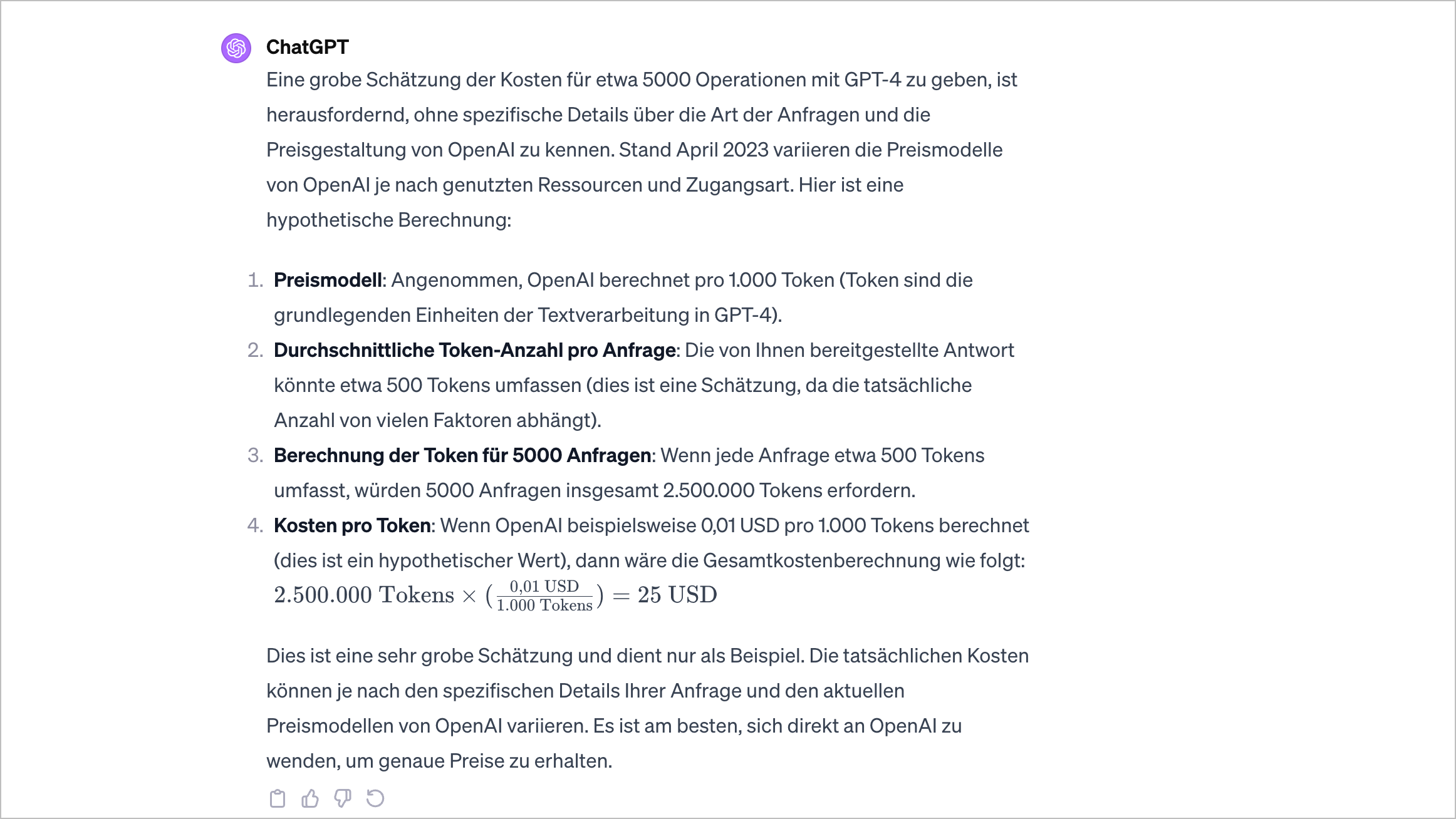

Wenn ich davon ausgehe über 100 Booklets mit ca. 30 Fragen und anderen Zusammenfassungen zu erstellen, komme ich zu einem Aufwand für eine Frage (von 100) auf ca. 50 KI Operationen.

Im Detail wären das dann 5000 KI Operationen oder Prompts.

Gehen wir, ganz grob von 25 Dollar aus, wenn man nicht GPT Turbo nimmt, dann wird es viel teurer.

Bei einigen Operationen kommen dann sicherlich schnell ein paar hundert Euro zusammen, also kann ich mit einer lokalen KI ein paar tausend Dollar im Jahr sparen.

Wie geht es weiter?

Die meisten Workflow habe ich in Make.com mit OpenAI gebaut, diese Workflows werde ich in lokale Workflows mit Rivet übertragen, das sichert mir auch Unabhängigkeit von OpenAI.